Nel mondo dei dati, il Data Wrangling è un po’ una parola d’ordine ultimamente. Vi abbiamo già fornito una panoramica generale qui. Nell’articolo di oggi, lo spieghiamo in modo più dettagliato e posizioniamo il Data Wrangling all’interno del ciclo del valore dei dati.

Sommario

- Promemoria sul Data Wrangling

- Step 1: acquisizione dei dati

- Step 2: archiviazione dei dati

- Step 3: utilizzo dei dati

Cosa è il Data Wrangling?

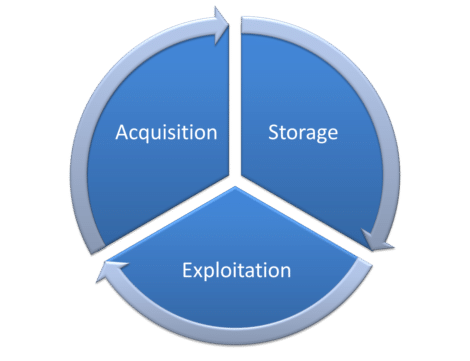

Data wrangling è un termine che si riferisce a una serie di attività necessarie per estrarre valore ai dati. Queste attività sono in gran parte localizzate al livello 1 (acquisizione) del ciclo di Data wrangling (schema sotto). Rientrano anche in piccola parte nella Parte 3 (funzionamento).

C’è una linea sottile tra la disputa dei dati da un lato e la preparazione/esplorazione dei dati dall’altro. Il termine è usato principalmente in un contesto in cui i dati sono “disordinati” e i volumi sono elevati.

L’uso commerciale del termine “data wrangling” è dovuto a Trifacta. Per segnare la differenza con la preparazione/esplorazione dei dati, Trifacta cosparge il Data Wrangling con l’intelligenza artificiale. Ma non facciamoci ingannare. Questo è un dispositivo commerciale.

crédits : Shutterstock

STEP 1: Acquisizione dei dati

L’acquisizione dei dati è il cuore dell’attività del data wrangling. È qui che si svolgono le attività relative alla preparazione e all’esplorazione dei dati.

Raccolta di dati da varie fonti

Una delle prime sfide è raccogliere informazioni che, oggi, vengono “divise” in una moltitudine di file. L’espansione dei dati è tale che una recente ricerca stima che l’azienda non elenchi il 52% dei “dati oscuri”. I file possono essere strutturati (excel, csv, file di tabelle relazionali) o non strutturati (XML, JSON, PDF). Possono provenire sia dall’interno dell’azienda che dall’esterno.

Fase di scoperta e comprensione dei dati

Durante questo passaggio proviamo a rispondere alla domanda: “Cosa contiene ogni fonte di dati?”. Per fare ciò è utile avere:

- uno strumento che permette di fare velocemente alcuni grafici per orientarsi visivamente nei dati (vedere la mia classifica delle caratteristiche importanti degli ETL)

- un dizionario di metadati.

Pulizia dei dati

Non è realistico pensare che i vostri dati saranno subito ”pronti per l’uso”. Dovrete prima pulirli, assicurandovi, ad esempio, che la colonna “genere” contenga solo 3 valori diversi (uomo, donna, sconosciuto) e non uno di più.

Arricchimento dei dati

Nell’era del GDPR e della cancellazione dei cookie di terze parti, l’arricchimento dei dati avviene principalmente incrociando fonti di dati interne. Interessante è anche l’arricchimento attraverso fonti di ”dati aperti”.

Un esempio abbastanza noto è il seguente. Una prima tabella contiene tutti i clienti con il loro nome. Una seconda tabella è un dizionario dei nomi che contiene, per ogni nome, il sesso (disponibile in open data qui). Incrociando queste 2 tabelle in base al nome possiamo indovinare il sesso del cliente.

In questo o nel passaggio precedente (pulizia dei dati), può essere interessante utilizzare la corrispondenza fuzzy per correggere eventuali errori che possono essere presenti qua e là.

Ristrutturazione dei dati

Se sono stati utilizzati dati non strutturati (XML, JSON, pdf), verranno ristrutturati (ovvero inseriti in formato tabellare).

crédits : Shutterstock

STEP 2: Archivio dei dati

Una volta che i dati raccolti sono stati ripuliti, strutturati e arricchiti, è il momento di archiviarli in un data lake (o, storicamente, in un data warehouse).

crédits : Shutterstock

STEP 3: Utilizzo dei dati dal data lake

A cosa servirebbero i dati se non li usassimo? Questo è lo scopo dell’ultima fase del ciclo di valutazione dei dati.

Il data mining in genere comporta:

Analisi dei dati

L’analisi dei dati può essere effettuata da un lato attraverso la visualizzazione, dall’altro attraverso l’identificazione di indicatori di performance (IEP). Un buon grafico o IEP ben progettati aiuteranno a evidenziare i processi di deterioramento. Capire perché un particolare processo si sta deteriorando (e correggerlo) spesso richiederà l’uso di un modello predittivo. Il Data Wrangling includerà l’implementazione di IEP a fini di monitoraggio.

Modellazione predittiva

La costruzione di questi modelli predittivi prevede:

Feature engineering: consiste nel creare le variabili corrette per ottenere modelli predittivi accurati e robusti. Alla fine di questo passaggio, otterremo un set di dati “migliorato” chiamato CAR o ABT.

L’utilizzo di strumenti di “machine learning” (più recentemente denominati “AI tools”) che analizzano le variabili disponibili per ottenere “modelli predittivi”. Si tratta di osservare gli schemi ricorrenti nel passato e il trarre conclusioni che ci permettano di prevedere il futuro.

Segmentazione

Nel marketing ci piacciono le segmentazioni. Tranne che la maggior parte delle volte, non si basano sul comportamento reale (osservato) del consumatore. È qui che i dati sono preziosi perché possono permettere di raggruppare i clienti secondo variabili a cui non avreste pensato spontaneamente.

crédits : Shutterstock

In conclusione

Abbiamo esposto le 3 fasi principali del ciclo di vita dei dati: acquisizione, archiviazione, utilizzo. Abbiamo riportato il concetto di data wrangling lì.

Questi 3 passaggi non sono necessariamente sequenziali. Infatti, durante l’esecuzione della fase 3 (utilizzo dati) è molto diffuso scoprire:

- che mancano dati cruciali affinché gli IEP calcolati siano rilevanti.

- quella parte dei dati raccolti è corrotta o non valida (es. viene eseguito un join che dovrebbe funzionare per il 100% delle righe, e ci rendiamo conto che le chiavi di join sono molto spesso errate, il che induce errori nel join e che solo il join in questione funziona il 20% delle volte).

Quando ciò accade, sarà necessario tornare al punto 1 per raccogliere ulteriori dati necessari o migliorare il processo di utilizzo per avere dati di migliore qualità. In pratica, molto spesso, all’interno della stessa azienda, ci sono diversi team che lavorano in parallelo su ciascuna di queste fasi.

Posted in Data e IT.