In de wereld van de data is data wrangling tegenwoordig een beetje een modewoord. In dit artikel gaven we u al een algemeen overzicht. In het artikel van vandaag lichten we het nader toe en plaatsen we data wrangling binnen de gegevenswaardecyclus.

Samenvatting

- Opfrissing over data wrangling

- #para1Stap 1: gegevensverzameling

- Stap 2: gegevensopslag

- Stap 3: gegevensverwerking

Wat is data wrangling?

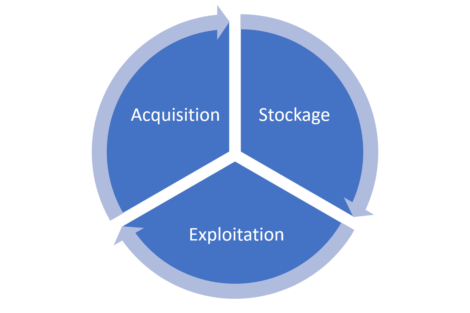

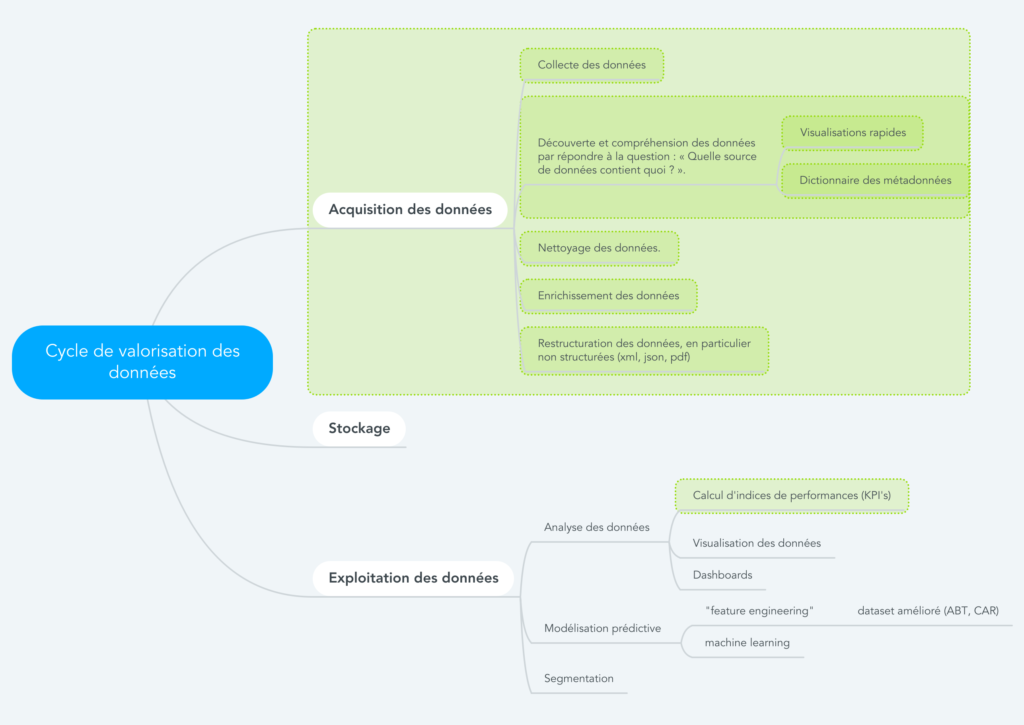

Data wrangling is een term die een reeks activiteiten aanduidt die nodig zijn om gegevens te valoriseren. Deze activiteiten bevinden zich grotendeels op niveau 1 (verwerving) van de gegevenswaardecyclus (zie onderstaand schema). Zij komen, voor een klein deel, ook voort uit deel 3 (verwerking).

Het verschil tussen data wrangling enerzijds en data preparation/data exploration anderzijds is klein. De term wordt doorgaans gebruikt in een context waarin gegevens “ongeordend” en de volumes groot zijn.

Het commerciële gebruik van de term “data wrangling” hebben we te danken aan Trifacta. Om het verschil aan te duiden met data preparation/ data exploration, gooit Trifacta een sausje van kunstmatige intelligentie over data wrangling. Maar laten we ons niet voor de gek houden. Het gaat hier om een commerciële kunstgreep.

crédits : Shutterstock

STAP 1: gegevensverwerving

Het verwerven van gegevens is de kern van data wrangling. Het is op dit niveau dat de activiteiten in verband met data preparation en data exploration plaatsvinden.

Verzameling van gegevens uit verschillende bronnen

Een van de eerste uitdagingen is het verzamelen van informatie die tegenwoordig in een veelheid van bestanden is “opgesplitst”. De uitbreiding van gegevens is zodanig dat een recente studie schat dat 52% van de “dark data” gegevens zijn die niet eens door het bedrijf worden vermeld. Bestanden kunnen gestructureerd (Excel, CSV, relationele tabelbestanden) of ongestructureerd (XML, JSON, PDF) zijn. Zij kunnen zowel van binnen als van buiten de onderneming komen.

Fase van het ontdekken en begrijpen van gegevens

Tijdens deze stap proberen we een antwoord te geven op de vraag: “Wat bevat elke gegevensbron?”. Om dat te doen, is het nuttig te beschikken over een tool waarmee u snel enkele grafieken kunt maken om u visueel te oriënteren in de gegevens (zie daarvoor mijn classificatie van de belangrijke ETL-functies) een metadata-woordenboek.

Opschonen van gegevens

Het is een illusie te denken dat uw gegevens direct “klaar voor gebruik” zullen zijn. U zult ze eerst moeten opschonen, door er bijvoorbeeld voor te zorgen dat de kolom “geslacht” slechts 3 verschillende waarden bevat (mannelijk, vrouwelijk, onbekend) en niet nog een bijkomende.

Gegevensverrijking

In het tijdperk van de GDPR en de afschaffing van cookies van derden gebeurt de verrijking van gegevens hoofdzakelijk door interne gegevensbronnen te doorkruisen. Verrijking via “open data”-bronnen is ook interessant.

Een bekend voorbeeld is het volgende. Een eerste tabel bevat alle klanten met hun voornaam. Een tweede tabel is een woordenboek van voornamen met, voor elke voornaam, het geslacht (hier beschikbaar in open data). Door deze 2 tabellen te kruisen op basis van de voornaam, kunnen wij het geslacht van de klant raden.

In dit stadium of in het vorige (opschonen van gegevens) kan het interessant zijn fuzzy matching toe te passen om fouten te corrigeren die hier en daar aanwezig kunnen zijn.

Herstructurering van gegevens

Indien er ongestructureerde gegevens zijn gebruikt (xml, json, pdf), moeten deze opnieuw worden gestructureerd (d.w.z. in tabelvorm).

crédits : Shutterstock

STAP 2: gegevensopslag

Zodra de verzamelde gegevens zijn opgeschoond, gestructureerd en verrijkt, is het tijd om ze op te slaan in een data lake (of, historisch gezien, in een data warehouse).

crédits : Shutterstock

STAP 3: verwerking van de gegevens uit het data lake

Wat is het nut van gegevens als we ze niet gebruiken? Dit is het doel van de laatste stap van de cyclus van gegevensvalorisatie.

Verwerking van gegevens houdt meestal in:

Analyse van de gegevens

Gegevensanalyse kan enerzijds door visualisatie en anderzijds door het vaststellen van prestatie-indicatoren (KPI’s). Een goede grafiek of goed opgezette KPI’s zullen verslechterende processen aan het licht brengen. Om te begrijpen waarom een bepaald proces verslechtert (en dit te verhelpen), zal vaak een voorspellend model worden gebruikt. De gegevensverwerking omvat de invoering van KPI’s voor toezichtsdoeleinden.

Voorspellende modellering

De constructie van deze voorspellende modellen impliceert: “feature engineering”: dit houdt in dat de juiste variabelen worden gecreëerd om nauwkeurige en robuuste voorspellende modellen te verkrijgen. Aan het eind van deze stap verkrijgen wij een “verbeterde” dataset, ook CAR of ABT genoemd.

Het gebruik van hulpmiddelen voor “machine learning” (meer recent “AI-instrumenten” genoemd) die de beschikbare variabelen analyseren om “voorspellende modellen” af te leiden. Dit houdt in dat terugkerende patronen in het verleden worden waargenomen en dat conclusies worden getrokken die het mogelijk maken de toekomst te voorspellen.

Segmentering

In marketing houden we van segmentaties. Meestal zijn ze echter niet gebaseerd op echt (waargenomen) consumentengedrag. Op dat vlak zijn gegevens zeer waardevol, omdat ze u in staat kunnen stellen klanten te groeperen op basis van variabelen waaraan u spontaan niet zou hebben gedacht.

crédits : Shutterstock

Tot besluit

Wij hebben u de 3 hoofdfases van de levenscyclus van de gegevens laten zien: verwerving, opslag, verwerking. We brengen het concept van data wrangling weer in beeld.

Deze 3 stappen zijn niet noodzakelijk opeenvolgend. Bij het uitvoeren van stap 3 (dataverwerking) wordt inderdaad vaak opgemerkt:

dat er cruciale gegevens ontbreken om de berekende KPI’s werkelijk relevant te laten zijn.

dat een deel van de verzamelde gegevens corrupt of ongeldig is (bijvoorbeeld: we voeren een koppeling uit die voor 100% van de rijen zou moeten werken en we realiseren ons dat de koppelingssleutels zeer vaak verkeerd zijn, waardoor er fouten in de koppeling ontstaan en dat de koppeling in kwestie slechts 20% van de tijd werkt).

Als dat zich voordoet, is het nodig zijn terug te keren naar punt 1 om aanvullende noodzakelijke gegevens te verzamelen of eenvoudigweg het extractieproces te verbeteren om gegevens van betere kwaliteit te verkrijgen. In de praktijk zijn er binnen hetzelfde bedrijf vaak verschillende teams die parallel aan elk van deze stappen werken.

Posted in Diverse.