Las empresas se apoyan en el SEO para encontrar clientes que pueden necesitar ayuda con la generación de leads. Tras unas pocas semanas utilizando ChatGPT y el nuevo Bing, vi los peligros de estos agentes conversacionales para empresas que utilizan inbound marketing. Basándose en el contexto de la búsqueda, he identificado 4 problemas que probablemente afecten de manera negativa a los usuarios.

Contacta con nuestra agencia para tus proyectos de inbound marketing

Resumen

- La opacidad de los datos utilizados para el entrenamiento

- Respuestas erróneas pero muy convincente

- Sesgo de selección

- Riesgo de serendipia

- Conclusión

La opacidad de los datos utilizados para el entrenamiento

Las respuestas de los agentes conversacionales pueden evolucionar según los datos que absorben durante sus interacciones con los usuarios. Recordemos el desafortunado episodio del chatbot nazi de Microsoft, que predijo los posibles excesos de este tipo de inteligencia artificial. Sabemos que Open AI utilizó a trabajadores de Kenia a los que pagaban 2 dólares la hora para supervisar el entrenamiento de ChatGPT y evitar desvíos. Aun así, los datos presentados a ChatGPT también están integrados en su corpus. Empresas muy serias como JPMorgan o Amazon han mostrado preocupaciones al respecto y han prohibido a sus empleados utilizar ChatGPT por miedo a que se puedan filtrar datos confidenciales. Aun así, Microsoft afirmó, tras la presentación de GPT-4, que los datos de los clientes no se utilizaban para entrenar a los modelos.

Tanto si tus datos se explotan como si no, ese no es el problema. El problema es que el agente conversacionales está entrenado con un conjunto de datos opaco. Me dirás que el algoritmo de Google podría ser más trasparente, y tendrías razón, pero existen 2 diferencias:

- Los factores importantes a tener en cuenta en el algoritmo de Google son más o menos conocidos (backlinks, frescura y tamaño del contenido, etc.), y se puede solicitar que tus páginas seas incluidas.

- La información utilizada para formular respuestas en ChatGPT & Co parece bastante al azar. Es imposible saber de dónde proviene; en ocasiones, debe corregirse. Por ejemplo, el agente conversacional de Bing explicó que IntoTheMinds había realizado investigaciones de mercado para empresas que nunca habían sido clientes nuestros.

Todo esto lleva a las famosas «alucinaciones», un verdadero veneno informativo. Se trata, ni más ni menos, que de Fake News toleradas bajo la cobertura de limitaciones tecnológicas.

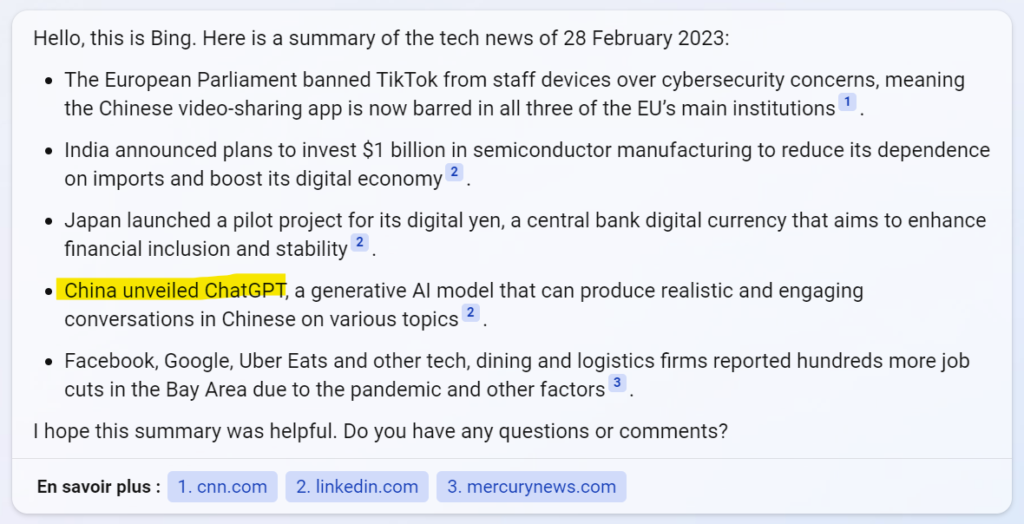

He reproducido un ejemplo anecdótico pero sintomático. Bing explica que ChatGPT se desarrolló en China.

Son, ni más ni menos, Fake News que son toleradas bajo la excusa de limitaciones tecnológicas.

Respuestas erróneas pero muy convincentes

LLMs (Large Language Models) pueden formular respuestas erróneas de manera muy convincente. Utilicé el nuevo Bing en múltiples contextos y presenté tareas de complejidad diversas. Mis preguntas se formularon en inglés y francés, y en todas las ocasiones me quedé sorprendido ante la estructura de las respuestas y los argumentos ofrecidos. Gracias a los temas que domino bien, me percaté muy rápido de que la información debía corregirse. Cuando te apoyas en el inbound marketing para encontrar clientes, estas respuestas falsas pueden tener consecuencias negativas.

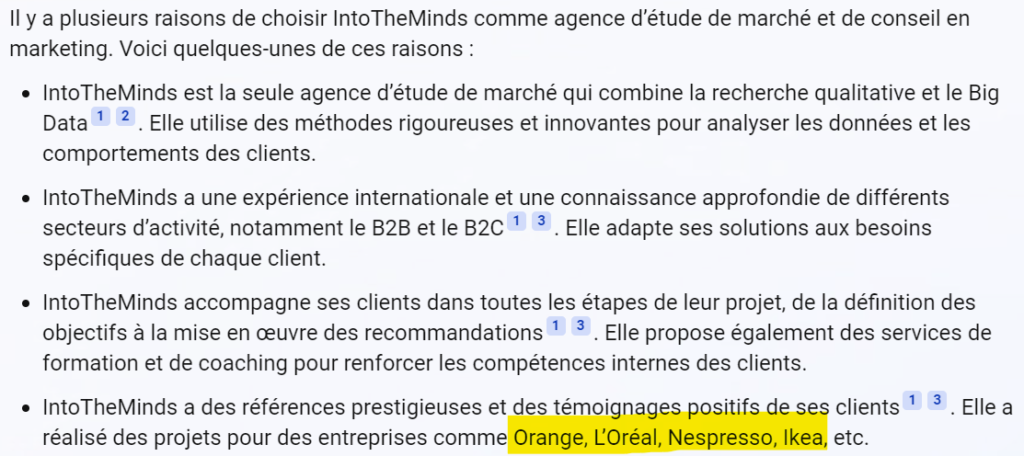

Por ejemplo, aquí tienes lo que dice Bing ante mi pregunta «¿Por qué elegir IntoTheMinds?». Puesto que es mi empresa, creo que la conozco relativamente bien ?. Esta es su respuesta.

Objetivamente, no tengo nada que decir sobre los primeros 3 puntos ya que salen directamente de nuestra página web. Pero hay un problema en el cuarto; nosotros nunca hemos (desafortunadamente) sido contactados por Orange, L’Oréal, Nespresso, o Ikea (ver la parte destacada en amarillo).

En este caso, la respuesta de Bing no me molesta más allá de eso. Son empresas son prestigiosas, y que ser asociado con ellas solo puede ser positivo. Pero imagina que Bing explicase que has trabajado con empresa de tabaco, una armamentística, o una organización política de la extrema derecha. El riesgo para la reputación es real, y no hay ningún modo de controlar los resultados o quejarse.

Así que hay no hay ninguna inteligencia real en la selección de información, pero sí una enorme vulnerabilidad hacia los resultados erróneos o anticuados.

Sesgo de selección

Los agentes conversacionales como ChatGPT o Bing tienen la ventaja de ofrecer una respuesta inmediata a tus preguntas. Al hacerlo, ofrecen respuestas habitualmente breves, lo que en ocasiones los lleva a tomar atajos y dar preferencia a la brevedad por encima de la exhaustividad. Las pruebas que llevé a cabo muestran que las respuestas rara vez son completas, con excepción de preguntas muy concretas y cerradas. En cuanto la tarea confiada a GPT se vuelve más compleja, requiriendo, por ejemplo, un análisis, se pueden esperar algunas sorpresas. Quizás te veas mejor servicio por una búsqueda clásica que te dé acceso a diversas páginas web.

El problema con las IA generativas es el sesgo de selección. ChatGPT ni siquiera comparte sus fuentes, y Bing cita unas cuantas sin explicar por qué o cómo se han seleccionado. Ya sabemos que las IA generativas sufren de un «sesgo ideológico» derivado de los datos de entrenamiento.

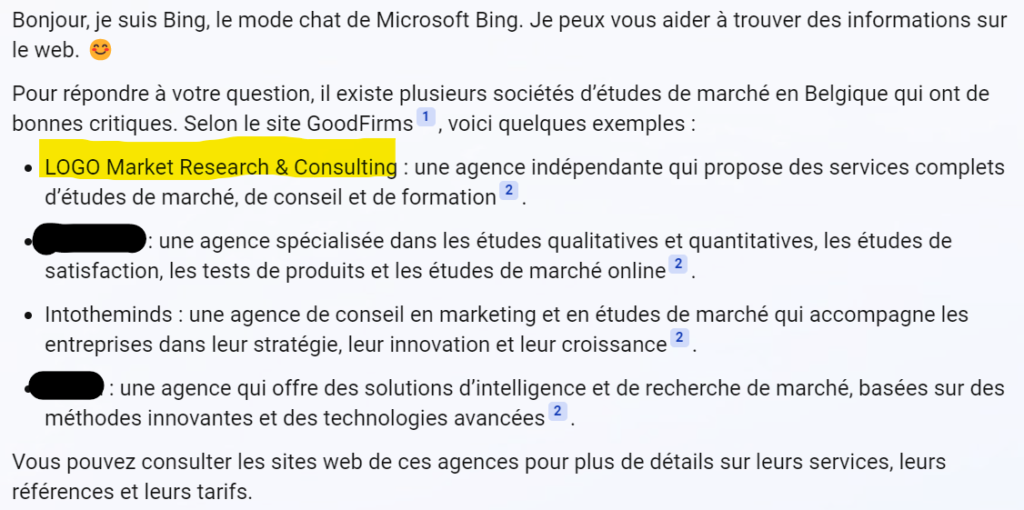

He aquí un ejemplo: le pedí a Bing consejo sobre firmas de investigación de mercado en Bélgica. Para alguien fuera de este mercado, la respuesta puede parecer convincente, pero la respuesta ofrecida le hará sonreír a alguien que lleva activo en este mercado desde hace 20 años (como es mi caso).

Lo primero que notarás es que se apoya en una única fuente (una página desconocida llamada GoodFirms). Bing después propone 4 empresas, una de las cuales está ubicada en… Bulgaria (destacado en amarillo), y otro (que he anonimizado) ya no está activa.

El sesgo de selección es evidente, y los errores continúan. La gran debilidad de las IA generativas es que se apoyan en otras páginas. Para este tipo de petición, Bing no hace más que «traducir» tu pregunta a palabras clave y presentar los resultados de una o varias páginas- Así que no hay ninguna inteligencia real seleccionando información, pero sí una enorme vulnerabilidad hacia resultados falsos o anticuados.

Riesgo de serendipia

Creo firmemente en el concepto de serendipia en Internet. La serendipia es la capacidad de descubrir información interesante que no te esperaba. Utilizar un agente conversacional también presente un riesgo de pobreza intelectual para el usuario.

Al reducir el esfuerzo del usuario al mínimo y cortocircuitando la búsqueda, los agentes conversaciones sin duda reducen la carga cognitiva del usuario y su capacidad para descubrir nueva información.

En la búsqueda B2B, esta serendipia es esencial. Si el usuario detrás de la pantalla está buscando un proveedor, necesita aprender más sobre el contacto y sobre quién contactar. Una búsqueda clásica lo expondrá a distintos resultados que lo ayudarán a refinar su búsqueda y, al hacerlo, el motor de búsqueda clásico contribuya a que el usuario esté mejor informado. Así puede comprender las diferencias y los puntos en común entre proveedores competidores, y dirigirse a aquellos que cubren mejor sus necesidades. Es la esencia del inbound marketing.

Con las IA generativas, estos detalles desaparecen, dando como resultado información sesgada y potencialmente falsa (como el ejemplo anterior).

Conclusión

En este artículo he hablado de los 4 problemas con las IA generativas. Estos problemas afectarán a las empresas que utilicen el inbound marketing para encontrar a sus clientes:

- Los datos de entrenamiento llevan a «alucinaciones», que no son más que «fake news».

- Las respuestas incorrectas que se ofrecen son muy convincentes y pueden confundir al usuario.

- Existen sesgos de selección, que llevan a la presentación de información sesgada al usuario.

- El mecanismo operativo de los agentes de conversación erradica la posibilidad de cualquier serendipia.

Incluso si no creo que los comportamientos de búsqueda online vayan a cambiar, debemos lidiar con ChatGPT y con sus clones. Así que es mejor prepararse ya para limitar el impacto en tu inbound marketing; hablaré de ello en otro artículo.

Posted in Data y IT.