Ik gebruik regelmatig 4 ETL-oplossingen: Alteryx, Tableau Prep, Talend en Anatella. Het zijn er maar 4 naast vele andere. De ETL-benchmark van G2 (Engelse site) vermeldt er maar liefst 40. In dit artikel leg ik u uit waarom de benchmark van G2 niet noodzakelijk relevant is en welke criteria ik gebruik om een vergelijking te maken tussen ETL-tools (Extract – Transform – Load) die het meest geschikt zijn voor uw behoeften.

Samenvatting

- Wat is een ETL?

- G2 benchmarkcriteria

- De belangrijkste criteria voor het kiezen van een ETL volgens mij

- Conclusie

crédits : Shutterstock

Inleiding: Wat is een ETL?

Als u dit artikel leest, is de kans groot dat u weet wat een ETL is. Laat me het nog even kort toelichten. Een ETL (of Extract – Transform – Load) is een oplossing voor de voorbereiding van gegevens. Met dit soort software kunt u :

- gegevens importeren (Extract) uit verschillende omgevingen

- ze verwerken (Transform) om ze kwalitatiever te maken, te verrijken, enz…

- en ze inladen (Load) in een nieuwe omgeving nadat je ze hebt voorbereid

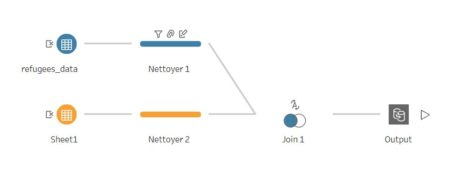

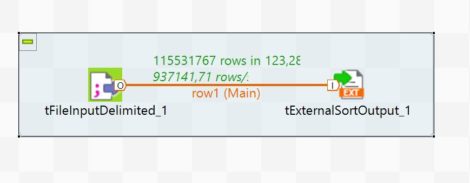

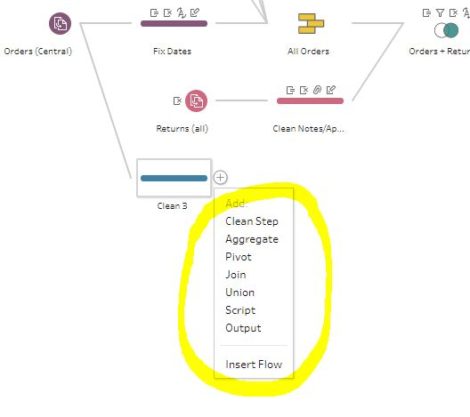

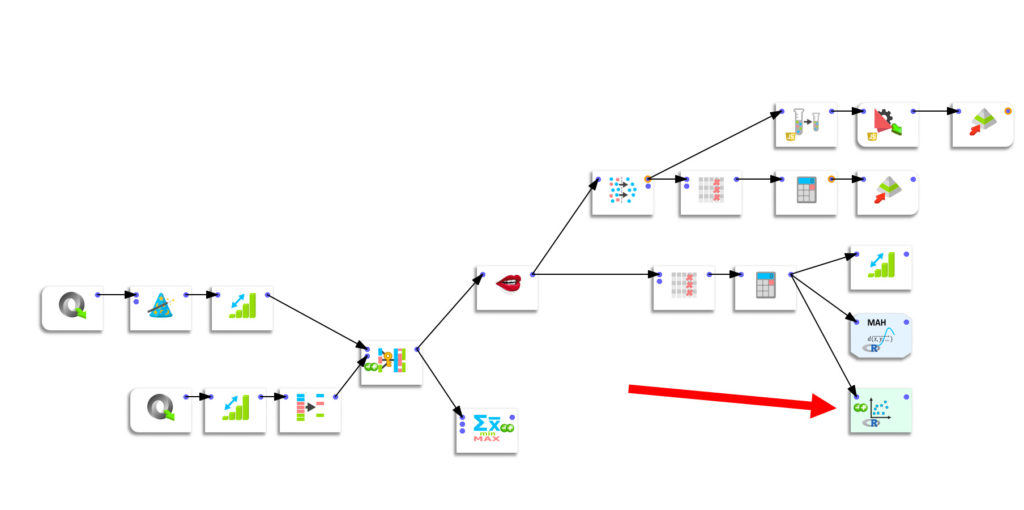

ETL is op zich geen instrument voor specialisten. De meeste ETL’s werken volgens het No-CODE principe, waarbij “boxes” worden gebruikt die overeenkomen met een bepaalde functionaliteit. Deze worden aan elkaar gekoppeld om een “pipeline” te vormen. Het is heel eenvoudig en zeer krachtig.

Ik geef u hierboven enkele voorbeelden van deze pipelines in 4 programma’s: Talend, Anatella, Alteryx, Tableau Prep. Zoals u kunt zien, zien ze er allemaal hetzelfde uit.

Mijn definitie van een ETL gaat dus om de dimensie van “gegevensoverdracht.

crédits : Shutterstock

G2 benchmarkcriteria

Laten we nu eens kijken naar de ETL-benchmark van G2. Voor degenen die G2 niet kennen, het gaat om een marktplaats die meningen van professionele gebruikers verzamelt over elk denkbaar type software. Ik denk dat hun slogan veel zegt:

Why is it easier to get unbiased information about a $100 hotel room than a $100,000 piece of software?

Ik denk dat het inderdaad absoluut cruciaal is om bij de aankoop van software over kwaliteitsvolle, indien mogelijk objectieve informatie, te beschikken. Maar al te vaak is de koper ten einde raad wanneer hij geconfronteerd wordt met een overvloed aan oplossingen voor dezelfde behoefte.

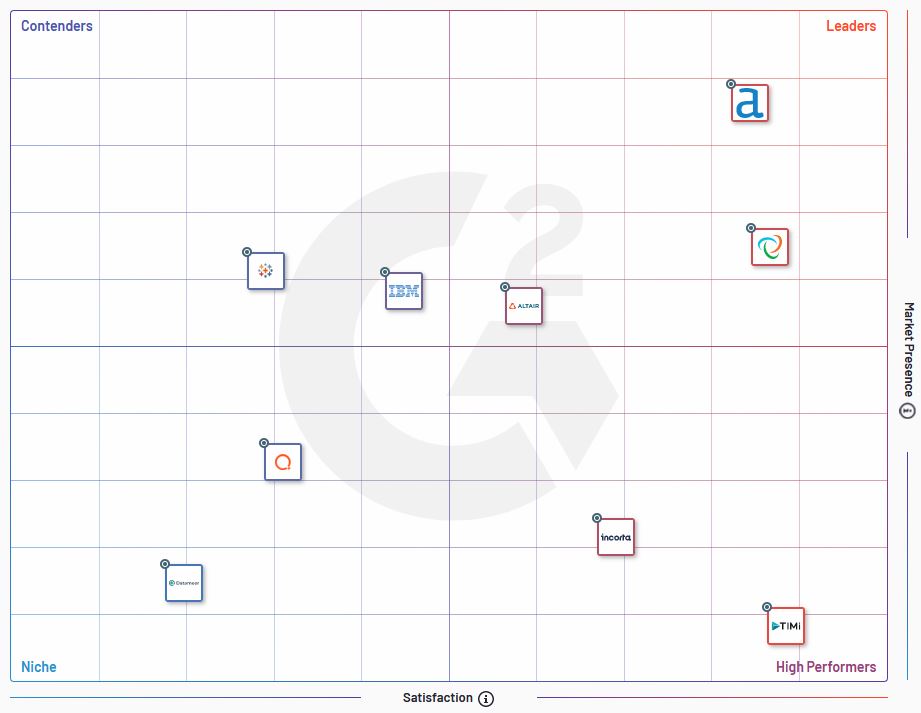

G2 heeft een categorie voorbehouden voor ETL’s (118 op het moment van schrijven van dit artikel [Engelse site]) en een andere voor “data preparation-oplossingen” (ongeveer 40, [Engelse site]). De benchmark bestaat uit 2 assen:

- marktaanwezigheid (“market presence”)

- tevredenheid

La carte est divisée en 4 quadrants qui ne seront pas sans vous rappeler les benchmark qui sont proposés par Gartner (les fameux “magic quadrants“) :

- Leaders

- Contenders

- Niche

- High performers

De kaart is verdeeld in 4 kwadranten die u zullen doen denken aan de benchmarks voorgesteld door Gartner (de beroemde “magic quadrants“[Engelse site]):

- Leaders

- Contenders

- Niche

- High performers

Eerlijk gezegd vind ik het principe van G2 goed, maar ik vraag me af of deze kaart echt nuttig is.

Vooreerst is er een terminologisch probleem. Bij de 118 tools die worden opgesomd in de ETL-categorie gaat het eerder om “EL”. U kunt er alleen maar van het ene naar het ander bestandsformaat mee gaan. De “echte” ETL’s waarmee u gegevens kunt transformeren zitten in de categorie “data preparation”. Dat brengt volgens mij heel wat verwarring met zich mee.

De voorgestelde indeling heeft inderdaad niet veel zin voor de ETL-gebruiker. Een kaart moet een besluitvormingsinstrument zijn. Het moet mogelijk zijn onmiddellijk de oplossing(en) te vinden die het meest geschikt is (zijn) voor het gebruik ervan. Maar hier gaat het om een “marketing”-visie die niet echt nuttig is voor degene die een technische oplossing zoekt voor een bepaald probleem.

De vraag is dus te weten welke ETL-functies het verschil maken. Dit is wat ik in het volgende deel bespreek.

crédits : Shutterstock

ETL: de belangrijkste selectiecriteria

Ik wil er eerst op wijzen dat ik niet beweer de absolute waarheid in pacht te hebben. Zoals ik in de inleiding al zei, bestaan er 118 programma’s in de G2 ETL-benchmark. Niemand kent ze allemaal en een vergelijking is daarom altijd subjectief.

In de volgende paragrafen zal ik de aspecten van een ETL uitwerken die voor mij belangrijk zijn en die ik als onderscheidend beschouw.

Criterium nr. 1: gegevensverwerking beschikbaar in de ETL

Dit is echt wel het belangrijkste criterium voor mij als ik morgen een ETL moest kopen. Hoe meer verwerkingsmogelijkheden (opschoning, transformatie, …) u ter beschikking hebt, hoe minder tijd u zult besteden aan de voorbereiding van uw gegevens. Want als de functies die u nodig hebt niet beschikbaar zijn, zult u ze zelf moeten programmeren. En wat mij betreft, gebruik ik liever No-Code dan dat ik mijn hoofd moet breken over het programmeren. Een concreet voorbeeld van een zeer nuttige eigenschap is fuzzy matching. Ik heb verschillende algoritmen van fuzzy matching en benaderingen in verschillende ETL’s vergeleken en sommige zijn duidelijk beter dan andere. Het is duidelijk dat het een groot voordeel is om dergelijke functies “aan boord” te hebben.

Criterium nr. 2: snelheid

Ik denk dat het belang van verwerkingssnelheid zeer onderschat wordt. Maar zoals ik in dit artikel al aantoonde, kunnen de verschillen zelfs bij triviale operaties zoals sorteren belangrijk zijn. Bij de behandeling van grote bestanden kan een slechte ETL al snel een hinderpaal zijn. Voor mij is snelheid essentieel omdat ik vaak grote bestanden verwerk en … ik hou niet van wachten.

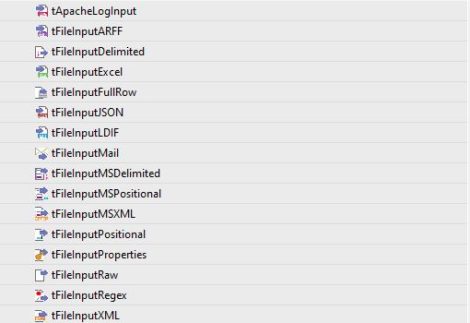

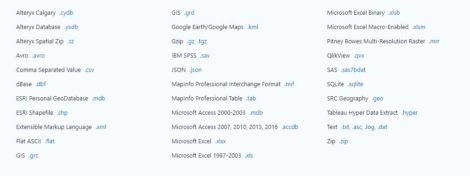

Criterium nr. 3: aantal ingangs- en uitgangsaansluitingen

Meer en meer connectoren worden van in het begin in ETL’s ingebouwd om aan de meest uiteenlopende behoeften te voldoen. Ik besteed bijzondere aandacht aan de outputverbindingen omdat ik gegevens meestal opnieuw invoer in een software voor datavisualisatie. Bij Tableau is het exporteren naar een .hyper-bestand bijzonder nuttig. Daarom waardeer ik vooral Anatella voor complexe verwerkingen en Tableau Prep voor de lichtere verwerkingen.

Criterium nr. 4: visualisatiefuncties

Het lijkt misschien ongerijmd om gegevens te willen visualiseren in een ETL, maar het is echt wel praktisch. Wanneer u aan datamining doet, is het essentieel om gegevens te kunnen visualiseren. Als u uw dataset elke keer moet exporteren en Tableau of Power BI moet openen, veel succes. In de pipeline hieronder, gemaakt met Anatella) ziet u dat ik een vakje heb waarmee ik een grafiek in R kan oproepen. Dat is erg handig omdat het me een idee geeft van de resultaten die ik kan verwachten.

Conclusie

Uiteindelijk denk ik dat de keuze van een ETL gebaseerd moet zijn op objectieve criteria, bepaald door de behoeften van de eindgebruiker. Elke bedrijfscontext is anders en zo ook de behoeften.

Ik zou daarom het volgende adviseren:

- Definieer de kenmerken die de gebruikers in staat stellen efficiënter te werken

- Kies een reeks instrumenten en test deze gedurende een voldoende lange periode in een “laboratoriumwereld”

- Beoordeel elke oplossing volgens haar criteria

- Maak een keuze

Deze aanpak lijkt mij veel gezonder dan te vertrouwen op een algemene benchmark.

Voel u vrij om commentaar te geven en uw keuze aan te geven! Bedankt.

Posted in big data.