Gli eventi del 2020 hanno accelerato il passaggio al telelavoro e alle relazioni digitali. Grazie alla digitalizzazione, è in corso anche un’altra trasformazione: la analytics transformation. Per affrontare questa rivoluzione dei dati, credo che le imprese non abbiano necessariamente gli strumenti giusti per preparare e analizzare i dati (preparazione dei dati o data wrangling).

In questo articolo, ho voluto risaltare il ruolo di questi strumenti nel funzionamento del business. In particolare, penso che possano contribuire ad aumentare l’efficienza, cosa che cercherò di dimostrare. In particolare, ho individuato 11 caratteristiche che determinano la perfetta soluzione di data wrangling/preparazione dei dati. Si tratta di un’estensione di una bozza che avevo già scritto sull’argomento.

Indice

- Trasformazione dei dati: una sfida per le risorse umane

- Le 11 caratteristiche di uno strumento esemplare di data wrangling/preparazione dei dati

Trasformazione dei dati: una sfida per le risorse umane

Da sempre, generare valore dai dati viene fatto da profili specializzati e costosi (dottori in data science, codificatori in R/Python). Nonostante l’outsourcing sia sempre utile per esigenze specifiche, ha un grande svantaggio: i consulenti esterni non capiscono il vostro business e hanno bisogno di tempo per cogliere le sottigliezze nascoste dei vostri dati.

Per trarre il massimo vantaggio dai vostri dati ed estrarre rapidamente tutto ciò che contengono ed il loro valore, è essenziale internalizzare le competenze sui dati e rendere disponibili strumenti utilizzabili da un numero abbastanza significativo di persone. L’uso di strumenti self-service di data wrangling da parte di tutti gli analisti mi sembra essenziale. Sono proprio queste persone che capiscono il problema da risolvere e che, quindi, hanno le maggiori probabilità di successo se gli vengono dati i mezzi tecnici.

Infatti, è essenziale internalizzare le competenze sui dati e mettere a disposizione strumenti utili al maggior numero di persone.

Questo approccio permette all’approccio analitico di uscire dal dipartimento “Data Science”. È anche il primo passo per instillare una cultura analitica globale ed essere più “agile”.

Ci sono molti tipi di persone all’interno delle aziende che manipolano i dati. Nel 99% dei casi, viene fatto con Excel, ed è qui che si possono realizzare sostanziali guadagni di efficienza. Infatti, dei buoni strumenti di “data wrangling” / “preparazione dei dati” offrono soluzioni a tutti i limiti di Excel (trasformazioni complesse, formati di dati multipli, volume, …). Io preferisco Anatella, di cui ho già parlato molte volte (per esempio, vedi qui).

Nei paragrafi seguenti, spieherò quali dovrebbero essere, secondo me, le 11 caratteristiche di uno strumento ideale per la preparazione e il wrangling dei dati.

Lo strumento di data wrangling deve essere uno strumento “self-service”…

Uno strumento di preparazione dei dati self-service permette ai vostri analisti di risolvere i problemi di business più velocemente. Possono analizzare i dati e il loro contesto, e con lo strumento giusto, sono autonomi nella loro risoluzione.

La preparazione dei dati deve essere veloce.

In genere, i data scientist passano più dell’85% del loro tempo a preparare i dati. Uno strumento che aumenta la velocità e la produttività della preparazione dei dati è quindi il benvenuto!

In particolare, i data scientist più esperti sanno che hanno bisogno di ridurre il tempo dedicato al “data wrangling” per fare un lavoro migliore. Ecco perché, proprio come gli analisti di business, i data scientist più esperti chiedono uno strumento “self-service” con un mouse, perché permette loro di avere un immenso guadagno di produttività e di tempo durante la costosa fase di “data wrangling”.

Lo strumento scelto deve essere federativo.

Mi sembra piuttosto essenziale possedere uno strumento che promuova e semplifichi la collaborazione tra analisti di business (business-oriented) e data scientists (technical-oriented). Senza questo aspetto unificante, sarà infatti difficile raggiungere una cultura analitica globale all’interno della vostra azienda.

L’aspetto federante di uno strumento di “preparazione dei dati” è forse il più difficile da realizzare perché le esigenze degli utenti aziendali sono spesso molto lontane dalle esigenze dei data scientist:

- Gli analisti del business evitano il codice e vogliono un accesso facile e immediato alle informazioni desiderate. Spesso lavorano con piccoli volumi di dati e non usano algoritmi molto complessi.

- Ai data scientists dei dati piace codificare, e scrivere mille righe di codice in R/Python non li fermerà (dopo tutto, stiamo parlando solo di una giornata di lavoro!). Spesso lavorano con grandi volumi e usano algoritmi complessi.

La possibilità di un lavoro iterativo

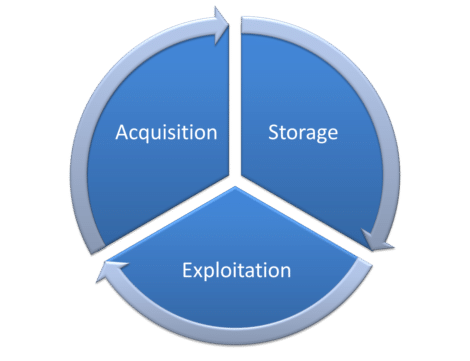

Il lavoro sui dati è infinito e dovrebbe essere inteso come un ciclo. Il ciclo rappresentato schematicamente qui sotto mostra che il lavoro è costante. È costantemente alimentato da nuovi dati: i dati aggiornati da un lato, e i dati provenienti da nuove fonti dall’altro.

L’elaborazione dei dati non è fine a se stessa. È un ciclo, un eterno riavvio. Gli strumenti utilizzati devono quindi essere in grado di gestire i cicli di aggiornamento.

Esempio di elaborazione iterativa dei dati

Molte aziende usano file Excel per raccogliere (e scambiare) i dati dei loro dipendenti. Cosa succede quando un dipendente decide di modificare leggermente la struttura di un file Excel per adattarlo meglio al problema aziendale?

Questo piccolo cambiamento richiede l’aggiornamento del processo di wrangling dei dati che raccoglie i dati da quei file Excel duplicati. Supponiamo che questo processo di wrangling dei dati sia opaco (perché è programmato in un linguaggio incomprensibile che solo gli addetti ai lavori capiscono il giorno in cui hanno scritto il codice). In questo caso, l’intero processo di raccolta dei dati è compromesso. Questo porta alla produzione di dati non validi e, in definitiva, a decisioni sbagliate. Quante volte avete sentito un collega dirvi che questo KPI è assurdo e dovrebbe essere ignorato? Questa (giustificata) mancanza di fiducia nei risultati analitici è spesso dovuta a strumenti di wrangling dei dati non abbastanza trasparenti.

Adattamento a grandi volumi di dati

Difendo l’idea di strumenti adattati all’elaborazione veloce di grandi volumi di dati (vedi il mio benchmark qui). Il tempo di elaborazione è correlato al volume di dati da elaborare. Tuttavia, troppo spesso, gli strumenti a disposizione degli analisti del business sono troppo lenti o non permettono loro di gestire grandi volumi di dati.

Uno strumento potente indipendente dalle risorse nel cloud

La questione della potenza di calcolo nella preparazione dei dati è, a mio parere, di fondamentale importanza. Per dare autonomia agli analisti, devono rispondere a tutte le loro domande indipendentemente dall’accesso (o meno) a un cluster di macchine nel cloud. Se la potenza di calcolo disponibile vi limita nelle vostre analisi, sarete frustrati.

Anche se è ormai elementare creare cluster di macchine nel cloud, il prezzo è ancora alto. A causa del prezzo elevato, un’azienda “normale” si limiterà a realizzare un cluster cloud (o anche due). L’uso di questo cluster sarà anche riservato a un piccolo numero di data scientists.

È facile capire che, in queste condizioni, lo sviluppo di una cultura analitica globale è compromessa. Se solo due persone hanno accesso al cluster, come si può aumentare l’efficienza ed evitare di creare difficoltà?

Oltre al prezzo proibitivo del cloud, bisogna affrontare anche la questione della sovranità dei dati quando vengono memorizzati su un cloud statunitense. Per saperne di più su questo argomento è possibile consultare la decisione “Schrems II” nel caso C-311/18 qui.

Uno strumento con costi fissi

Non mi piace per nulla l’idea di non sapere in anticipo quanto mi costerà l’analisi dei dati. Eppure, questa è la situazione in cui si trovano tutte le aziende che usano AWS o Azure per l’elaborazione dei dati. La variabilità dei costi rende impossibile prevedere quale sarà la prossima fattura. In altre parole, c’è un costo variabile associato ad ogni domanda analitica.

Una proprietà intrinseca dei cluster cloud è il “costo variabile” associato ad ogni domanda analitica. Questo è forse il “Key Selling Point” delle offerte dei giganti del cloud: “Paghi solo per quello che usi”.

Un data scientist motivato sarà quindi la fonte di costi variabili più elevati, perché farà un uso intensivo del cluster cloud per capire nel miglior modo possibile i dati. Al contrario, un data scientist meno motivato causerà costi variabili più bassi.

Il monitoraggio dei costi di elaborazione nel “cloud” sanziona gli scienziati dei dati più attivi e più motivati.

Se la valutazione dei data scientist si basa sui costi che generano, ci ritroviamo in una situazione paradossale. Quelli che lavorano di più e sono più motivati sono penalizzati. Pertanto, l’uso “parsimonioso” del cluster diventa la norma. Poiché questa situazione si verifica di continuo, esistono ormai molti strumenti specializzati nel “monitoraggio del cloud” che permettono di sanzionare e tagliare l’accesso alle risorse di calcolo a tutti i data scientist poco motivati. In queste condizioni, è facile capire che mantenere i data scientist motivati rischia di essere complicato.

Infine, uno strumento di data wrangling che lavora su “costi variabili” (come il 99% delle soluzioni cloud) penalizza, scoraggia e impedisce ai migliori di lavorare.

Semplificare l’industrializzazione

Un buon strumento di data wrangling dovrebbe permettervi di industrializzare e automatizzare facilmente le “ricette” sviluppate dal vostro team.

Ecco alcune caratteristiche specifiche che mi sembrano essenziali:

- facile integrazione con qualsiasi programma di pianificazione (ad esempio, MS-Windows task scheduler o Jenkins).

- rapida implementazione all’interno della vostra attuale infrastruttura IT o di altri linguaggi o altri framework di dati. Per esempio, chiamare una procedura di wrangling dei dati da un piccolo script Python è un must.

- abbastanza robusto da gestire un improvviso aumento del volume dei dati senza andare in crash.

Strumento integrato

Alcune soluzioni ETL non sono ETL perché la parte di “trasformazione” (la “T”) è assente o insufficientemente sviluppata. Io do la priorità agli strumenti che coprono tutte e 3 le parti del ciclo dei dati: acquisizione, stoccaggio, sfruttamento. Deve essere possibile passare da una parte all’altra senza difficoltà e senza perdita accidentale di informazioni.

Molteplicità di connettori

Ho già parlato molte volte dell’importanza di avere più connettori a disposizione. Oggi i dati arrivano dappertutto, in sempre più formati, e a volte proprietari.

Numerose funzionalità di trasformazione dei dati

Si tratta di un punto che ho già menzionato molte volte, e che mi sembra essenziale in un approccio “No Code”. È necessario avere un numero massimo di “scatole” pre-programmate per coprire le operazioni quotidiane di trasformazione dei dati.

Naturalmente, tutte le soluzioni ETL degne di questo nome hanno una vasta gamma di “scatole” disponibili. Ma alcune ne hanno più di altre (per esempio, Anatella), il che può essere molto comodo.

Quest’ultimo punto sembra ovvio, ma, cosa del tutto sorprendente, ci sono poche soluzioni software che soddisfano questa esigenza. Infatti, molti fornitori di software si accontentano di fornire un’ampia connettività e dimenticano completamente l’aspetto della “trasformazione dei dati”, che è una componente altrettanto necessaria, se non di più. Volete qualche esempio? Eccone due.

Corrispondenza fuzzy

Estremamente utile per riconciliare 2 database quando si ha una qualità non eccellente. Eppure, conosco solo una soluzione che lo propone (vedi qui per maggiori informazioni).

La funzione cardine

Se state realizzando la visualizzazione di dati, è importante essere in grado di ruotare i vostri dati. Tuttavia, anche qui, il 99% delle soluzioni di data wrangling non lo propone (in Anatella, le caselle si chiamano “flatten” e “unflatten”).

Posted in Data e IT.