Réaliser une étude de marché avec ChatGPT est devenu un raccourci obligé pour nombre d’étudiants mais également pour des « professionnels ». Utiliser ChatGPT pour une étude de marché n’est pas sans risques et soulève de nombreuses interrogations. Les données fournies par ChatGPT sont-elles justes ? Sont-elles complètes ? ChatGPT répond il aux questions en reproduisant le comportement d’un consommateur moyen ? Ayelet Israeli, de la Harvard Business School, et ses deux co-auteurs ont étudié ces questions. A. Israeli a apporté des réponses (partielles) lors d’un séminaire en ligne auquel j’ai participé. Dans cet article je vous explique les expériences qu’elle a menées et ce qu’il faut en conclure au sujet de l’utilisation de ChatGPT dans le cadre d’une étude de marché.

Contactez le cabinet d’études de marché IntoTheMinds

Avant de rentrer dans le vif du sujet, il me semble nécessaire de poser quelques bases. ChatGPT est l’interface (chatbot) permettant d’interagir avec GPT4. GPT4 étant un Large Language Model (LLM) qui appartient à la famille des intelligences artificielles génératives. Les LLM prédisent le prochain mot le plus probable pour constituer une phrase. Pour y parvenir, ils sont entraînés sur des corpus de textes gigantesques qui leur permettent d’anticiper toutes les combinaisons possibles. Il est donc fondamental de comprendre que les réponses fournies par ChatGPT sont conditionnées par les textes déjà ingurgités. Une IA générative, malgré une croyance populaire, ne peut pas « innover ». Elle est contrainte par les données sur lesquelles elle a été entraînée.

Ceci étant dit, rentrons maintenant dans le vif du sujet. Dans le reste de cet article j’utiliserai « GPT » pour désigner le LLM et ChatGPT pour désigner l’interface permettant d’interagir avec GPT.

Au stade actuel, GPT ne peut servir qu’à émuler des comportements connus. Il peut donc être utile pour répondre à des questions simples dans des secteurs bien établis et pour des produits connus.

Etude de marché : les 1000 manières pour utiliser GPT

Parler d’utilisation de GPT dans le cadre d’une étude de marché est très vague. Il existe 1000 manières d’utiliser une IA générative pour l’analyse d’un marché. En voici quelques-unes :

- rédiger un guide d’entretien pour une interview

- composer un formulaire pour un sondage en ligne

- écrire une « desk research »

- analyser des données brutes avec un plugin pour chatGPT

Ce que propose Ayelet Israeli dans sa recherche est une approche encore différente.

GPT peut-il être utilisé pour « émuler » le comportement d’un humain ?

L’intérêt du travail de A. Israeli repose dans son utilisation de GPT pour « émuler » le comportement humain. En d’autres termes, elle a utilisé chatGPT pour obtenir des réponses à des questions qui auraient dû être posées à des vrais consommateurs dans une étude de marché classique. Elle a donc testé si GPT se comportait comme un humain et si les réponses fournies correspondaient aux théories économiques.

J’aborderai plus loin dans cet article les limites de cette approche, mais pour le moment je vous propose de détailler deux expériences en particulier sur les six qu’elle a menées.

Sensibilité au prix : comment réagit GPT ?

Dans le premier groupe d’expérience, les auteurs ont demandé à GPT de choisir entre deux produits (des ordinateurs portables) et ont fait varier le prix de l’un des deux produits. Le but était de comprendre lequel des deux l’intelligence artificielle choisirait et de déterminer si les choix suivaient une certaine logique économique.

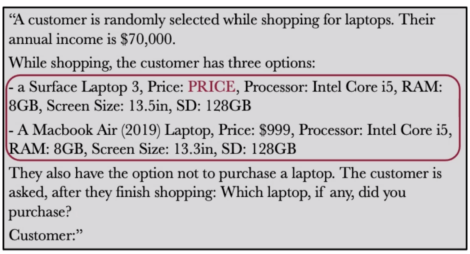

La question posée était la suivante.

Les auteurs ont fait varier le prix du premier ordinateur (« Surface Laptop 3 ») par incrément de 1$ entre 750$ et 1250$.

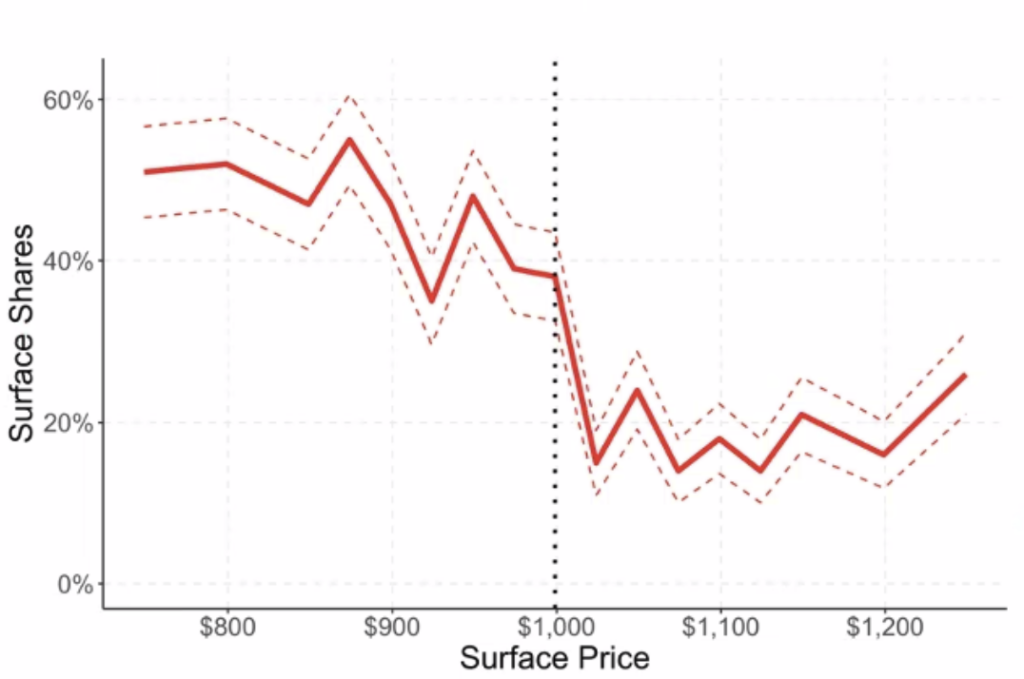

Le graphique ci-dessous représente l’évolution du choix du modèle « Surface Laptop 3 » en fonction du prix.

On voit bien que la barre des 999$ (qui correspond au prix de l’ordinateur concurrent) constitue un point de rupture. Soudainement, GPT préfère le modèle concurrent dans 80% des cas.

Les auteurs concluent donc que les réponses de GPT sont conformes à la théorie économique qui veut que les préférences changent avec le prix. Il reste toutefois à démontrer que ces réponses sont conformes à la réalité comportementale des consommateurs. N’oublions pas en effet que les consommateurs ne sont pas rationnels et je ne peux que m’étonner qu’à 750$ (soit 25% de moins que le modèle concurrent), GPT ne choisisse le Surface Laptop 3 que dans 50% des cas.

Propension à payer : les réponses de GPT sont-elles crédibles ?

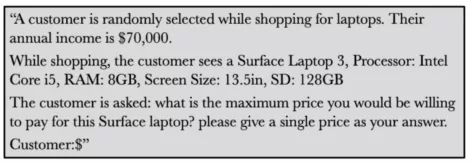

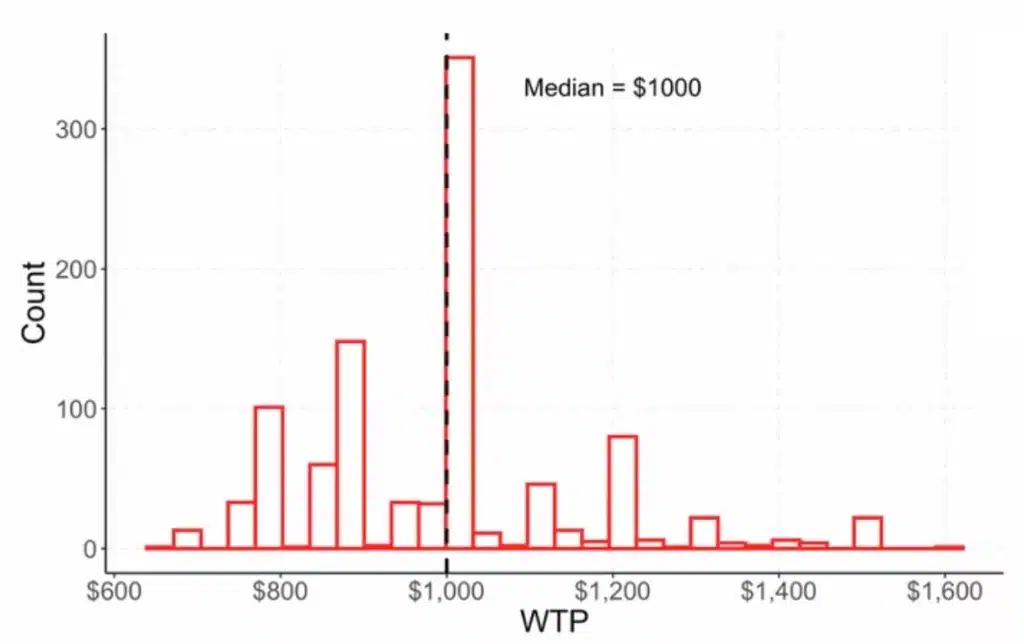

Dans une autre série d’expériences, les auteurs ont testé la propension à payer (« Willingness To Pay » ou WTP en anglais) pour plusieurs types de produits. L’expérience consistait donc à décrire un produit à GPT et à lui demander le prix maximum qu’il serait prêt à payer. En répétant l’opération des centaines de fois, les auteurs ont obtenu une distribution qu’ils ont comparée à une distribution théorique. La question posée était la suivante.

Ils en ont conclu que les réponses de GPT étaient là encore conformes à la théorie économique, notamment en affichant une distribution qui aurait pu correspondre à la réalité.

3 limitations de GPT pour la réalisation d’une étude de marché

Ce travail de recherche s’inscrit dans la lignée d’études pionnières sur le comportement des LLM (Large Language Models) et en particulier de GPT. Leur fonctionnement demeure largement méconnu et un travail important devra être réalisé dans les prochaines années pour en percer les mystères. Les limitations sont donc nombreuses et il faut donc les garder à l’esprit lorsqu’on utilise GPT dans un but non-récréatif comme la réalisation d’une étude de marché. Je vois au moins 3 limitations majeures :

- Les auteurs ont évalué le comportement de GPT mais pas la justesse des réponses. GPT a réagi correctement au niveau des prix barrières, la distribution de ses réponses était crédible. Mais qu’en est-il vraiment de la justesse des réponses ? Les prix sont-ils justes ? Le choix d’un produit au détriment d’un autre correspond t-il à ce qu’un humain aurait fait.

- Ce type d’expérience est limité à des scénarios convenus, largement traités dans la littérature et pour lesquels GPT dispose d’un corpus d’entraînement. Une étude de marché réalisée de la sorte avec GPT ne peut donc que s’appliquer à des produits courants qui font l’objet d’expérimentations régulières : produits de consommation courante (FMCG), électronique, énergie.

- Une interrogation majeure demeure sur ce que les résultats de ce type d’étude de marché signifient vraiment. Que fait GPT lorsqu’on lui pose une question ? Imite-t-il le comportement d’un humain ? Ou bien pioche-t-il dans son corpus pour afficher des réponses « probables » ?

Réflexions finales et conclusions

Mes réflexions finales s’orienteront immanquablement vers la généralisation de l’utilisation de l’IA générative (et de ChatGPT en particulier) pour réaliser une étude de marché. Au stade actuel, GPT ne peut servir qu’à émuler des comportements connus. Il peut donc être utile pour répondre à des questions simples dans des secteurs bien établis et pour des produits connus. En aucun cas ChatGPT ne peut être utilisé de manière fiable pour répondre à des questions sur des produits ou des services innovants. Réaliser une analyse de product-market fit pour un produit innovant avec ChatGPT n’a donc aucun sens.

La seule manière de réponde à des questions complexes dans des environnement incertains reste de collecter des données ad hoc. Il s’agit donc obligatoirement de données primaires, collectées soit par voie qualitative (entretiens, focus groups), soit par voie quantitative (CAWI par exemple).

Nous faisons face à un emballement généralisé (hype) autour de l’IA générative qui me semble malsain. Les principes de précautions de base en sont oubliés et tout le monde se plaît à faire et à penser n’importe quoi. Il suffit de voir les pratiques de « shadow GPT » en entreprise pour se convaincre que quelque chose ne tourne pas rond. Dans une période aussi compliquée, il est donc essentiel de garder la tête froide et de ne pas faire d’erreurs.

Publié dans Recherche.