Zu einer Zeit, in der Amazon bereits 35% seines Umsatzes dank der algorithmischen Empfehlung erzielt und zwei neue Personalisierungstools (Discover und Showroom) einführt, kündigt Gartner das Ende der Personalisierungsalgorithmen bis 2025 an. Diese zweideutige Ankündigung scheint eine genauere Analyse zu verdienen.

Inhalt

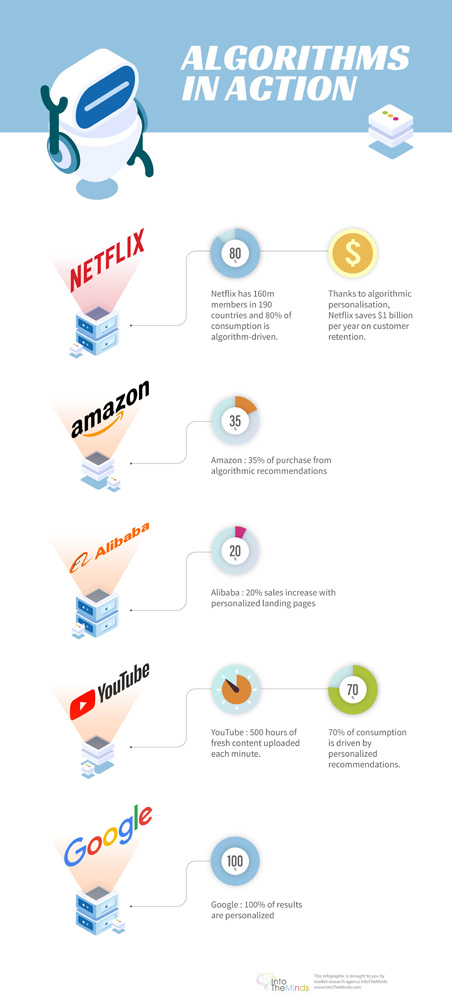

- Infografik zu Personalisierungsalgorithmen

- Der Zweck der algorithmischen Personalisierung

- Warum die Personalisierung aufgeben?

- Problem #1: Datensammlung und -integration

- Problem #2: ROI

- Schlussfolgerungen

Infografiken

Was ist der Zweck der algorithmischen Personalisierung?

Personalisierungsalgorithmen sind in unser digitales Leben eingedrungen. Der erste von ihnen (Google) personalisiert unsere Ergebnisse auf seiner Suchmaschine. Während auf YouTube jede Minute 500 Stunden an Inhalten hochgeladen werden, schlagen die Empfehlungsalgorithmen dieser Plattform vor, welche Inhalte uns interessieren könnten und starten sogar automatisch deren Wiedergabe. Die Empfehlung ist in der Welt der Medienplattformen besonders nützlich (es wird geschätzt, dass 70-80% des Netflix-Konsums von Empfehlungsalgorithmen stammt), aber das ist noch nicht alles. In der Welt des E-Commerce sind Algorithmen allgegenwärtig (Amazon z.B. bezieht 35% seines Umsatzes aus diesen Algorithmen, in die es seit 1994 investiert), im B2B sind virtuelle Assistenten ebenfalls in voller Entwicklung, um Verkäufern (Auto, Versicherung, …) vorzuschlagen, was sie ihren Kunden verkaufen sollen. Sie ermöglichen es also, die Beziehung zwischen dem Verkäufer und dem Kunden zu personalisieren.

Warum sollten Marketer die Personalisierung aufgeben?

Algorithmische Personalisierung ist ein heißes Thema, seit sie sich auf alle digitalen Aspekte unseres Lebens ausgebreitet hat, insbesondere beim Medienkonsum. Eli Pariser hat das Konzept der Filterblasen erfunden, über das wir auf diesem Blog viel gesprochen haben (siehe z.B. hier unseren Vorschlag zur Filterblasen-Klassifizierung). Auch wenn ihre Existenz immer noch diskutiert wird und eine neue Definition nötig ist, gehen einige Unternehmen den umgekehrten Weg dieses Konzepts, wie z. B. HBO mit diesen menschlichen Empfehlungen (Service und Website in den meisten Ländern nicht verfügbar; siehe das Video unten).

Aber Gartners These basiert auf ganz anderen, rein wirtschaftlichen Argumenten.

- Persönliche Daten sind immer schwieriger zu erhalten.

- Vermarkter würden vom Return on Investment der algorithmischen Personalisierung enttäuscht sein.

Was den ersten Punkt angeht, können wir Gartner keinen Vorwurf machen. Vor allem in Europa hat die GDPR bestimmten Praktiken einen Riegel vorgeschoben. Auch wenn der Nutzen der GDPR für den Verbraucher noch umstritten ist (siehe unsere Studie zu diesem Thema), ist es klar, dass die Unternehmen viel vorsichtiger geworden sind als zuvor. Außerdem wurde vor dem Inkrafttreten der GDPR eine große Säuberungsaktion durchgeführt, die dazu führte, dass alle persönlichen Daten, für die keine Zustimmung dokumentiert war, gelöscht wurden.

Der zweite Punkt erfordert einen ausführlicheren Kommentar, da die Position von Gartner auf den ersten Blick schwer zu verteidigen ist. Laut Gartner werden 80% der Marketer ihre Personalisierungsbemühungen bis 2025 aus zwei Hauptgründen aufgeben:

- Unzureichende Kapitalrendite

- Die Schwierigkeit, persönliche Daten zu sammeln und zu integrieren

Problem 1: Datenerfassung und -integration

In diesem Punkt können wir Gartner nur zustimmen. Was wir bei unseren Kunden beobachten, ist tatsächlich eine große Schwierigkeit, die Daten zu integrieren. Das Fehlen einer soliden Grundlage und insbesondere das Fehlen eines einzigen Client-Repository (CRU) führt dazu, dass viele Unternehmen das Unmögliche versuchen: Den Abgleich von disparaten Datenbanken. Dies führt zu Kosten für die Entwicklung spezifischer Systeme, die schwer zu pflegen sind. Aus diesem Grund plädieren wir seit mehreren Jahren für die ausschließliche Verwendung von First-Party-Daten – eine Position, die wir auch auf der jährlichen BAM-Konferenz wieder verteidigt haben und lesen Sie das ausführliche Positionspapier, das wir anlässlich des BAM-Kongresses veröffentlicht haben).

Unser Rat

Anstatt stur Daten schwacher Qualität zu sammeln und zu integrieren (denken Sie an das Sprichwort „Scheiße rein, Scheiße raus“), wagen Sie es, bei Null anzufangen. Und stellen Sie vor allem sicher, dass Sie die folgenden vier Prinzipien einführen, um das Vertrauen Ihrer Kunden/Benutzer zu entwickeln, um mehr Daten zu sammeln:

- Klären Sie Ihre Anwender über die Verwendung und den Wert ihrer Daten auf.

- Geben Sie ihnen die Kontrolle zurück.

- Verlassen Sie sich nur auf Daten von Erstanbietern.

- Vertrauen schrittweise aufbauen.

Problem Nr. 2: Unzureichender ROI

Unzureichender ROI kann durch verschiedene Faktoren verursacht werden: Zu geringer Nutzen oder zu hohe Kosten. Unserer Meinung nach sind die zu hohen Kosten vor allem auf den Entwicklungs- (und Wartungs-) Aufwand zurückzuführen, der betrieben werden muss. Egal, ob Sie ein Personalisierungssystem „von der Stange“ kaufen oder selbst eines entwickeln, es gibt kein Personalisierungssystem, das über Nacht integriert werden kann.

Wenn der Nutzen zu gering ist, müssen Sie sich fragen, ob die gesetzten Ziele realistisch sind und wie Sie Ihre Bemühungen messen. Zu oft stellen wir fest, dass zu ehrgeizige Ziele gesetzt werden und parallel dazu keine geeignete Messmethode (z. B. A/B-Tests) vorhanden ist. Der ROI sollte anhand von KPIs (Key Performance Indicators) gemessen werden, die durch die Personalisierungsalgorithmen beeinflusst werden können. Da andererseits Anpassungen zum Erreichen der Ziele unabdingbar sind, muss das Personalisierungssystem diese auch zulassen. Algorithmen „von der Stange“ erfüllen zwar bestimmte Anforderungen, können aber bei der Anpassung an bestimmte Ziele oder Daten eingeschränkt sein.

Am Ende stimmen wir mit Gartner überein. Die Enttäuschung ist oft groß bei denen, die Personalisierungsalgorithmen ausprobieren. Aber es ist nicht das System, das daran schuld ist. Es sind die Menschen, die es auswählen und implementieren. Ihre mangelnde Erfahrung und Unerfahrenheit bei der Implementierung solcher Systeme führt dazu, dass sie sich auf Projekte einlassen, die auf lange Sicht vielleicht nicht profitabel sind.

Fazit: Das Ende der Personalisierung passiert nicht morgen

Die von Gartner vorgebrachten Argumente machen Sinn und entsprechen der Realität vieler Situationen, denen wir begegnet sind. Zusammenfassend lässt sich sagen, dass Unternehmen einerseits unverhältnismäßig hohe Erwartungen an Personalisierungsalgorithmen stellen, andererseits aber nicht über die notwendige Mindestbasis verfügen, um sicherzustellen, dass die richtigen Daten optimal gesammelt und konsolidiert werden können.

Dies wird unweigerlich dazu führen, dass viele Personalisierungsprojekte bei Unternehmen, die sich auf solche Projekte eingelassen haben, ohne darauf vorbereitet zu sein, gestoppt werden. Das bedeutet aber keineswegs, dass der Personalisierungsmarkt schrumpfen wird. Im Gegenteil: Die immer schnellere Digitalisierung unseres Lebens, die Produktion immer größerer Datenmengen, wird den Bedarf an immer mehr Personalisierung in den Interaktionen zwischen Unternehmen und ihren Kunden verstärken. Wir werden daher nur den Niedergang von Projekten erleben, die auf der falschen Grundlage gestartet wurden. Im Gegensatz dazu werden andere Vermarkter, die sich der technischen und funktionalen Voraussetzungen bewusster sind, parallel Projekte starten, die Früchte tragen werden.

Posted in Big data, Marketing.