La conférence RecSys 2020 a eu lieu la semaine dernière sous une forme inédite à cause de la pandémie. J’aurais du être à Rio de Janeiro avec le reste de la communauté scientifique pour parler de systèmes de recommandation comme chaque année. Le Covid-19 a changé nos plans et la conférence s’est déroulée online. Malgré ce déplacement dans la sphère virtuelle, le décalage horaire et l’absence de rencontres physiques, j’ai quand même pu en profiter. Dans cet article je reviens sur la keynote d’ouverture qui a été donnée par Filippo Menczer de l’université d’Indiana. Intitulée « 4 raisons pour lesquelles les médias sociaux nous rendent vulnérables à la manipulation », elle a permis de faire le point sur une matière complexe et d’exposer au grand jour le rôle réel des réseaux sociaux dans la formation des chambres d’écho.

5 idées à retenir

- les personnes les plus vulnérables à la manipulation ne sont pas exposées aux personnes qui tentent de rétablir la vérité (fact checking)

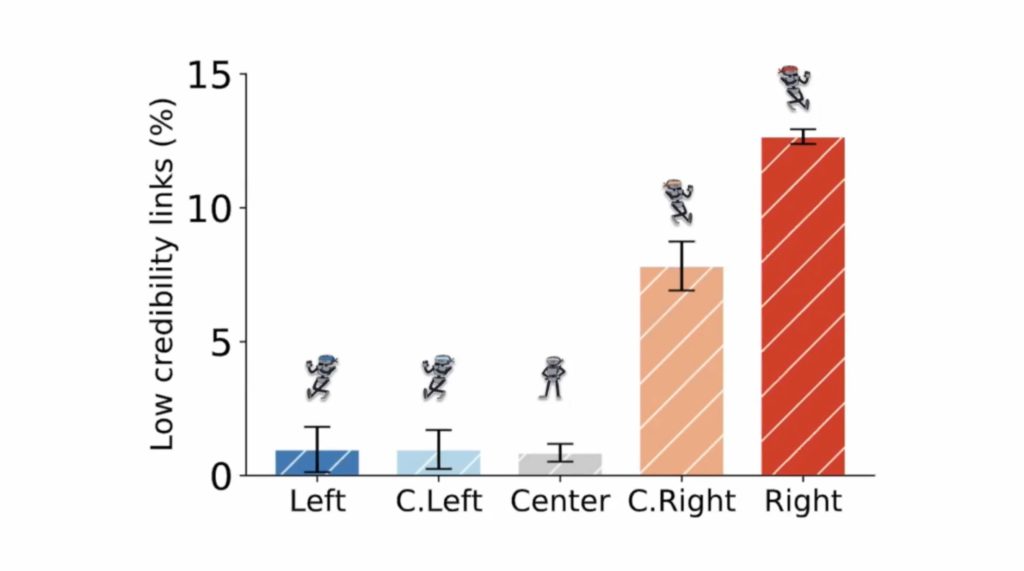

- les conservateurs sont ceux qui ont la probabilité la plus élevée de partager de fausses informations

- la viralité des fausses et vraies informations suit quasiment la même dynamique

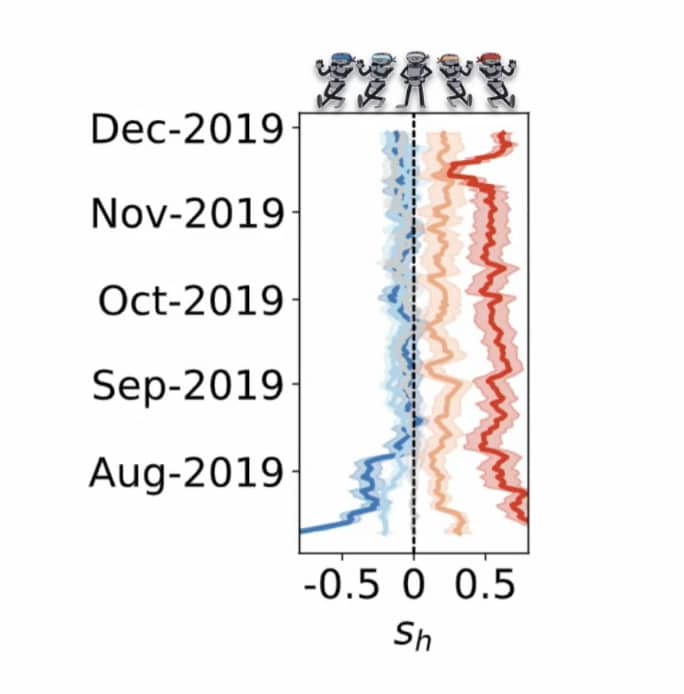

- twitter tend à rapprocher les opinions des Démocrates du centre, mais pas celles des Républicains

- lorsque les bots infiltrent 1% d’un réseau, ils sont en mesure de le contrôler et de faire chuter la qualité des informations diffusées.

Idée 1 : les chambres d’écho

J’ai déjà consacré de nombreux articles sur ce blog aux chambres d’écho et aux bulles de filtres.

Le 1er point abordé par Filippo se référait à sa propre expérience des chambres d’écho suite à une « attaque » dont son laboratoire a fait l’objet au travers d’une campagne de désinformation.

Les biais sont en nous, et les médias sociaux sont un catalyseur qui accélèrent la formation des chambres d’écho.

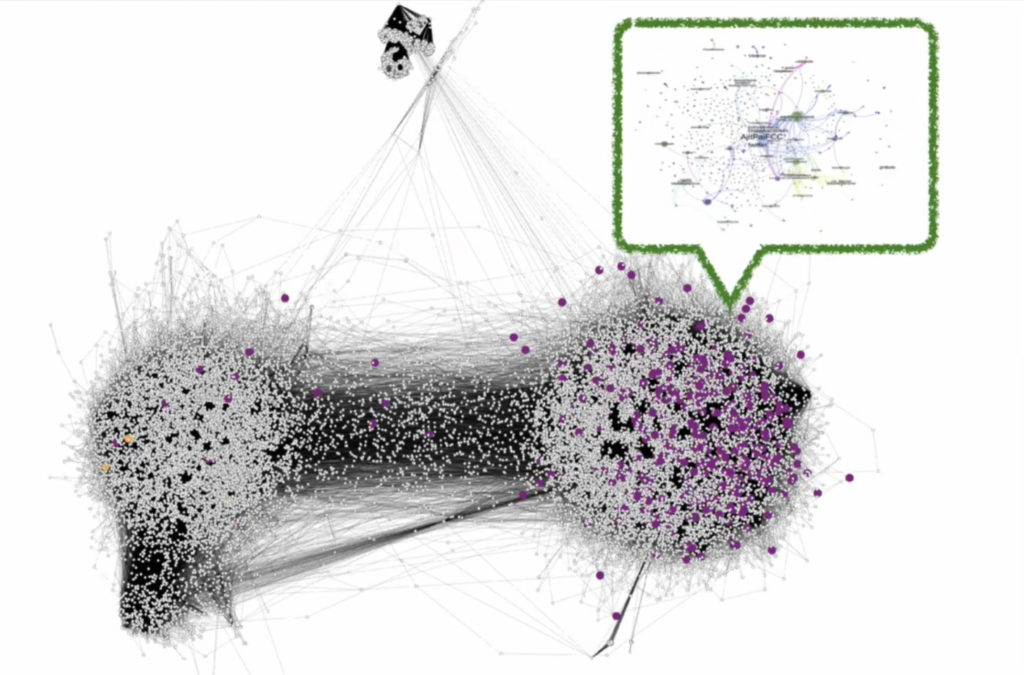

L’étude de ces attaques a permis de montrer qu’elles trouvaient leur origine dans un groupe de personnes / bots de l’aile conservatrice (républicains). C’est ce qu’illustre l’image ci-dessous, sur laquelle vous pouvez voir que le réseau de désinformation (entouré en vert) est entièrement englobé dans les comptes twitter situés à droite de l’échiquier politique. Deux point jaunes (fact checkers) à gauche restent inaudibles. En d’autres termes, les personnes vulnérables aux tentatives de désinformation n’ont pas la possibilité d’être exposées aux faits réels qui leur permettraient de changer d’opinion.

Les chambres d’écho ne sont pas tant le fait des algorithmes de recommandation (un argument de plus contre les bulles de filtres) mais plutôt le résultat du comportement même des individus. Dans une simulation très éclairante, l’équipe de Fillipo a montré comment se forment les chambres d’echo. C’est l’action « unfollow » (arrêter de suivre quelqu’un) qui peu à peu conduit à la formation des chambres d’écho. Et comme le signale Filippo, les systèmes de recommandations qui ont pour ambition de contrecarrer les chambres d’écho ne parviennent au mieux qu’à ralentir leur formation. Les biais sont en nous, et les médias sociaux sont un catalyseur qui accélèrent la formation des chambres d’écho. Si vous voulez approfondir le sujet, je vous conseille la lecture de cet article.

Vous pouvez jouer vous-même avec cette simulation via la page du laboratoire de Fillipo.

En résumé ces chambres d’écho sont le résultat de biais inhérents à nos croyances, notamment politiques. Ce qui ne manquera pas d’interpeller c’est la preuve scientifique qui est apportée de la probabilité plus élevée des conservateurs et ultra-conservateurs de partager ce qu’on appelle pudiquement des « liens de basse crédibilité » (en clair, des fake news).

Idée 2 : le trop-plein d’information

Il n’aura échappé à personne que nous vivons dans une société où l’information est devenue omniprésente. La charge cognitive n’a jamais été aussi grande dans l’histoire de l’humanité. Les systèmes de recommandation sont donc potentiellement utiles pour trouver l’information requise. Le problème c’est que dans le fatras d’informations qui nous arrivent chaque jour, il y a du bon et du moins bon. La question se pose dès lors de savoir si nous sommes en mesure de faire le tri en fonction de la qualité de l’information. La réponse est non.

La viralité des vraies informations et des fausses suit quasiment la même dynamique. Les vraies informations ne sont que marginalement plus populaires que les « fake news ». C’est inquiétant.

Pour comprendre cette dynamique il est essentiel de savoir que la viralité d’un post dépend en fait de la structure du réseau social. Un réseau social qui ressemble à un réseau « humain » permet d’obtenir les meilleures performances. A cet effet la présence de « hubs » est essentielle (ces personnes relais dans le réseau qui sont connectées à beaucoup de monde).

Idée 3 : le biais de la plateforme

Twitter est régulièrement accusé par les conservateurs de biaiser les résultats et de cacher certaines informations au profit des démocrates.

Ce que Fillipo Menczer a montré c’est que Twitter tend à « normaliser » les opinions … des démocrates. Le graphique ci-dessous montre que les opinions les plus à gauche (en bleu et en Août 2019) se rapprochent du centre avec le temps qui passe. C’est encourageant car il faut rapprocher les courants opposés pour rétablir la communication, et éviter les chambres d’écho.

Le problème c’est que la même dynamique ne s’applique pas au conservateurs (en rouge). Leur opinion reste, malgré le temps qui passe, très ancrée à droite.

L’algorithme n’y est pour rien. Jérôme Fourquet parle dans son livre d’archipels et c’est exactement ce qu’on observe ici. Un archipel conservateur qui a coupé les ponts avec les personnes dont l’opinion est différente, et qui entretient son conservatisme en vase clos.

Idée 4 : la manipulation des réseaux sociaux par les bots

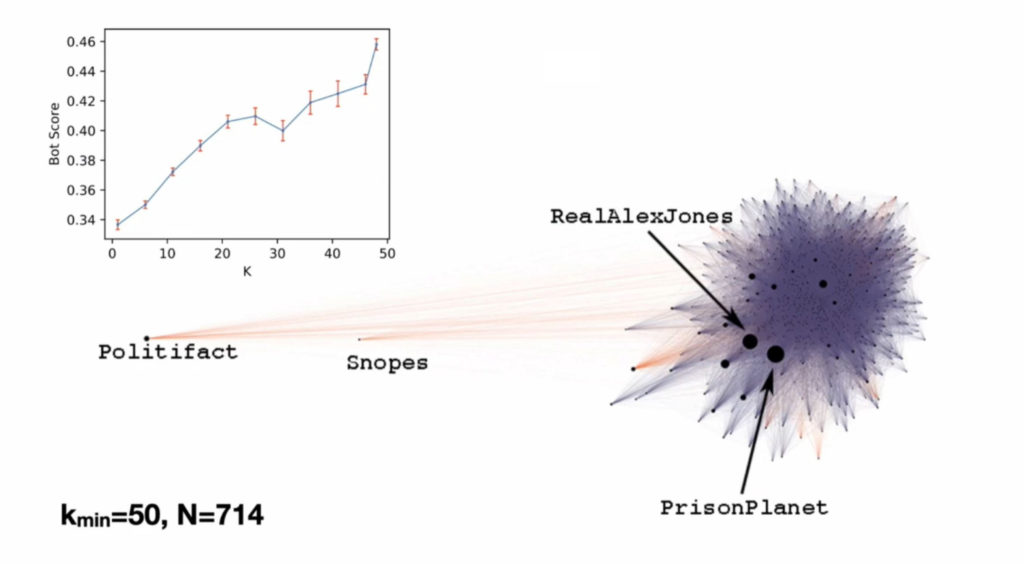

Filippo Menczner a été le premier à observer l’activité d’un bot sur twitter en 2010. L’illustration ci-dessous est en fait le premier témoignage de l’activité de 2 bots qui retweetaient automatiquement leurs message comme dans un infernal jeu de ping-pong. L’épaisseur de la ligne correspond au nombre de retweets (plusieurs milliers).

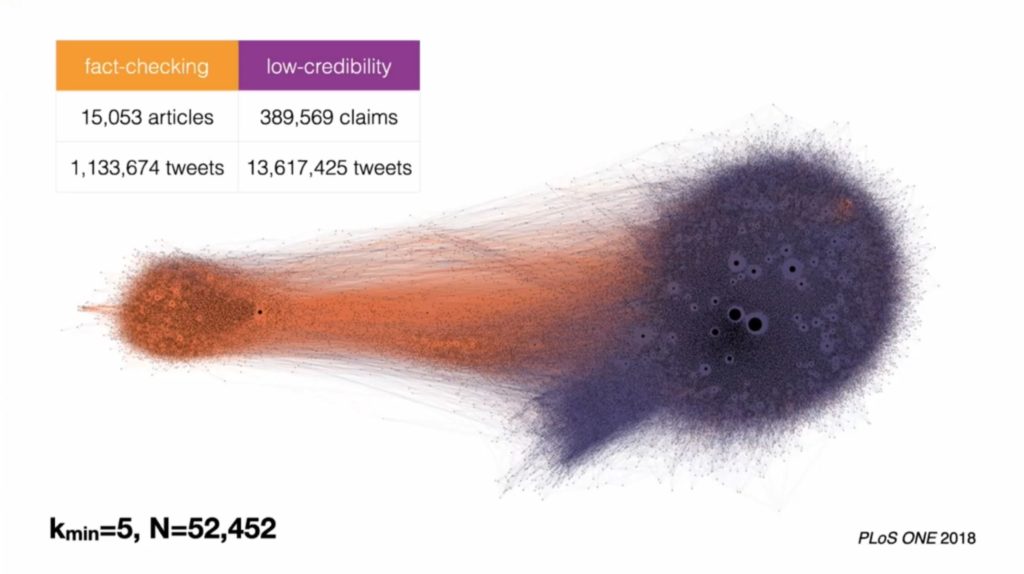

La visualisation ci-dessous est quant à elle issue de Hoaxy, une autre application du laboratoire de Filippo Menczer. Cette application permet de visualiser la vitesse de diffusion des fakes news et des vraies informations. L’exploitation des données issues de l’activité des utilisateurs montre, logiquement, que les comptes qui partagent des fake news sont tout à fait isolés de ceux qui partagent des informations vraies.

En rentrant dans le cœur de la nébuleuse « fake news » à droite, on découvre que la majorité des diffusions de fake news sont le fait de bots. Les comptes qui sont les plus proches du « cœur » de ce réseau sont plus susceptibles d’être des robots. Le matraquage d’une fausse information est une technique utilisée par les bots pour remplir un réseau et faire apparaître une information fausse sur le fil twitter d’un humain duquel il espère un retweet.

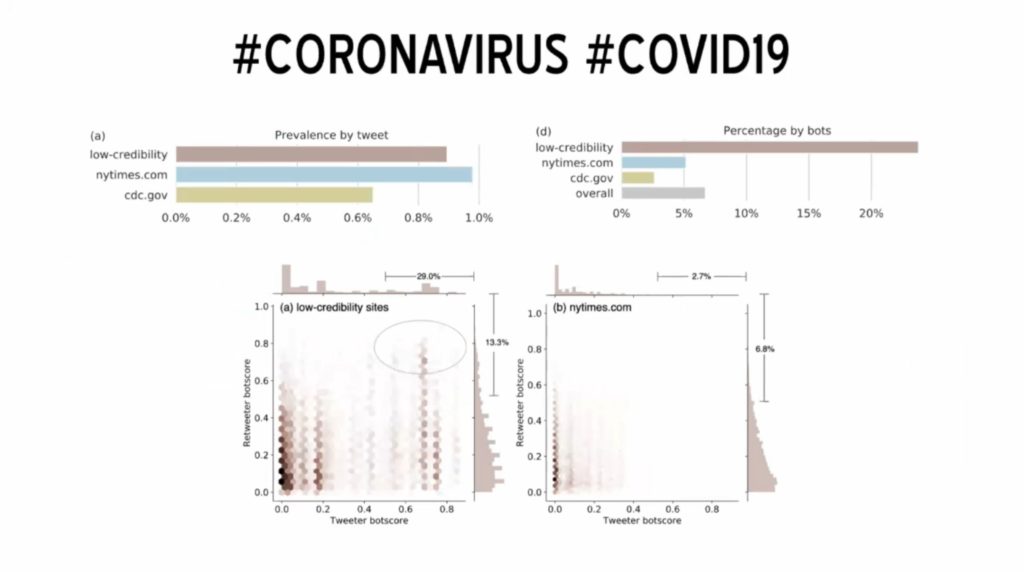

La plupart des des retweets sont en fait le fait d’humains. Mais ces derniers retweetent à la fois des vraies infos et des fausses. C’est l’effet de ce matraquage par les bots, certains pouvant diffuser un lien vers une « fake news » plusieurs milliers de fois. La conséquence c’est que les humains vont diffuser les deux types d’informations, comme le montre l’exemple ci-dessous au sujet du Covid. Comme vous pouvez le voir sur le graphique dans le coin supérieur gauche, la diffusion d’informations peu crédibles est au même niveau que celui d’informations émanant de sources légitimes (NY Times ou cdc.gov).

D’autres analyses montre que lorsque les bots infiltrent 1% du réseau, ils sont en mesure de le contrôler et de faire chuter la qualité des informations diffusées.

Publié dans Recherche.