L’IA enrichit l’expérience des visiteurs de l’exposition Alechinsky

Dans un contexte où la culture est sévèrement impactée par la crise du Covid, il est plus que jamais important de fidéliser les visiteurs. J’avais proposé différentes pistes de réflexions pour améliorer l’expérience client dans les musées et vous propose aujourd’hui de découvrir une initiative des Musées Royaux des Beaux-Arts de Bruxelles. Une exposition consacrée à l’artiste belge Pierre Alechinsky vient de s’ouvrir qui donne un très bel aperçu de sa pléthorique production. A cette occasion un...

La place du data wrangling dans le cycle de valorisation des données

Dans le monde de la data, le data wrangling est un peu le mot à la mode ces derniers temps. Nous vous en avons déjà proposé un aperçu général ici. Dans l’article d’aujourd’hui nous vous l’expliquons plus en détail et positionnons le data wrangling au sein du cycle de mise en valeur des données. Sommaire Rappel sur le data wrangling Etape 1 : l’acquisition des données Etape 2 : le stockage des données Etape 3 :...

Excel domine le monde de l’entreprise … et ce n’est pas près de changer

Rares sont les marques qui ont un taux de pénétration de 100%. Microsoft est de celle-là. Plus fort encore, on peut affirmer qu’un de ses produits, Microsoft Excel, est utilisé par 99,99% des entreprises dans le monde. Microsoft Excel est partout. Vous n’en pouvez plus ? Et bien il va falloir vous y faire car ce n’est pas près de changer. Mais si Excel a des qualités indéniables, il faut aussi s’interroger sur son efficacité pour...

Data Wrangling : définition, étapes, outils [guide 2021]

Le terme « Data wrangling » est également connu sous le nom de « Data Munging ». Ce terme technique peut sembler intimidant à première vue. L’ambition de cet article est de le démystifier. Le data wrangling est défini comme une partie importante d’un processus plus large appelé « préparation des données« . Le traitement des données est le processus mis en œuvre pour collecter, sélectionner, structurer, enrichir et finalement transformer les informations dans le but de répondre à une question spécifique....

Benchmark ETL : quel temps faut-il pour traiter 1 milliard de lignes ?

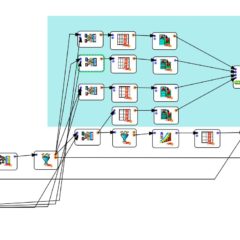

Dans un article précédent, je mettais en avant l’importance de la vitesse de traitement pour le choix d’une solution de data preparation (ETL). J’avais réalisé un premier benchmark entre Alteryx, Tableau Prep et Anatella sur un fichier de 108 millions de lignes. Cette fois-ci j’ai répété l’opération sur 1,039 milliard de lignes et j’ai ajouté Talend au benchmark. Les résultats sont inattendus puisque les vitesses de traitement varient dans une proportion allant de 1 à 20....

Data preparation : comment choisir la solution adaptée à vos besoins ?

J’utilise régulièrement 4 solutions de data preparation : Alteryx, Tableau Prep , Talend et Anatella. Le benchmark de G2 en recense pas moins de 40. Dans cet article je vous explique pourquoi le benchmark G2 n’est pas forcément pertinent, et quels critères utiliser pour comparer les solutions ETL (Extract – Transform – Load) les plus adaptées à vos besoins. Sommaire Qu’est-ce qu’un ETL ? Les critères du benchmark G2 Les critères de choix d’un ETL les...

Benchmark : quel ETL choisir pour manipuler des fichiers de grande taille ?

En matière de data preparation, force est de constater qu’une grande partie des processus se passent encore « offline », avec des archives extraites des bases de données relationnelles. Et quand il s’agit pour les data engineers de manipuler ces archives, mieux vaut avoir un ETL qui tienne la charge. Dans l’article d’aujourd’hui je vous propose d’aborder le sujet passionnant des fichiers de grande taille en comparant 2 ETL’s que j’utilise au quotidien : Alteryx et Anatella. Seulement...

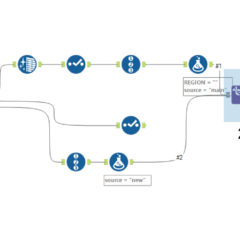

ETL : utilisation des opérateurs ternaires pour l’extraction de données dans Excel

Comment utiliser un outil ETL pour extraire des informations d’un fichier Excel et les réconcilier ? Après vous avoir expliqué une méthode pour automatiser l’extraction à partir de nombreux fichiers Excel, dans le billet d’aujourd’hui je vais plus en profondeur et vous explique comment j’ai utilisé des opérateurs ternaires pour extraire l’information voulue. Présentation du problème Le problème auquel j’ai été confronté est relativement courant. Vous avez un fichier peu structuré rempli par un utilisateur ou...

Comment automatiser l’extraction de données à partir de fichiers Excel

Voici le problème auquel j’ai été confronté récemment. Un client m’a demandé de traiter des données qui provenaient de centaines de fichiers Excel. Franchement je n’avais pas envie de passer des heures à extraire manuellement ces données. Alors j’ai automatisé le processus grâce à Anatella et ai visualisé les données sous Tableau par la suite. Voici un petit tuto de data preparation et une bonne manière de traiter vos données plus efficacement avec un ETL digne...

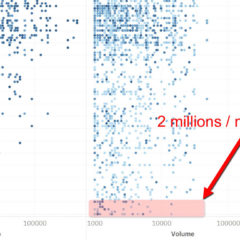

SEO : 50000 pages analysées et 2m de requêtes facilement accessibles

Dans cette étude SEO nous avons analysé 50000 pages web, couvrant 185 mots-clés en lien avec la « data science » dans 16 pays. Le résultat principal révélé par cette étude est que des opportunités inexploitées existent de se classer en 1ère page de Google sur des mots-clés anglais en dehors des pays anglophones. Les données brutes viennent d’Ahrefs. Nous avons utilisé Anatella pour préparer et nettoyer les données, et Tableau pour les visualiser. Voici ce que...

Data preparation : définition, exemples, conseils [guide 2023]

Pour parler de la data preparation, quoi de mieux que de partir d’un constat. Dans le monde de la data, il y une règle que tout le monde connaît : 80% du temps d’un data scientist est passé à préparer ses données ; et seulement 20% à travailler vraiment dessus, notamment à travers ce qu’on appelle la datavisualisation. Dans cet article nous donnons un coup de projecteur sur la data preparation : les problèmes les plus...

Les 5 niveaux de la data visualisation : exemples et conseils [guide ultime]

Après avoir écrit mon guide de la data visualisation, j’ai voulu développer dans un article séparé les 5 niveaux de la visualisation des données que j’y esquissais brièvement. Si vous voulez savoir où vous en êtes au niveau de votre pratique de la BI (Business Intelligence) et de la dataviz, cet article est fait pour vous ! Sommaire Introduction Niveau 0 (pas de dataviz) Niveau 1 (vous travaillez encore sous Excel ?) Niveau 2 (Vive les...

Data visualisation : définition, exemples, outils, conseils [guide 2023]

La Data Visualisation (« visualisation des données » en français, ou « dataviz » pour les initiés) est la discipline qui s’attache à représenter sous forme graphique des données brutes. Visualiser les données doit avoir pour but de créer de la valeur. Ces dernières années ont vu l’émergence de nouveaux outils et pratiques autour de la data visualisation, mais également celle de nouveaux métiers. J’ai mis cet article à jour en Avril 2023 pour refléter les évolutions des solutions de...

[Podcast] L’apprentissage des outils numériques aux enfants

Nathalie Kuborn (We Are Coders), Gaëlle Girardeau (Cood) et Christophe Coquis (Geek Junior) nous parlent de l’apprentissage de l’informatique, des outils numériques et de l’introduction à la culture numérique pour les enfants : marché, parcours et conseils. Marché de l’apprentissage des outils numériques aux enfants L’émergence d’un besoin Le marché de l’apprentissage informatique aux enfants est en pleine émergence. Pour Gaëlle, cela s’explique par le fait que nous soyons tous de plus en plus équipés en...

La data science expliquée par un enfant

Le terme « data science » reste opaque pour le commun des mortels. Pourtant ces 2 mots sont souvent repris dans la presse comme l’une des disciplines les plus tendance du moment. Pour démystifier les termes utilisés dans le domaine de la data, nous avons lancé une série de vidéos animées par notre présentateur-vedette : Pierre-Raffaele (10 ans au moment du tournage) 🙂 Après le succès de sa série sur « Le Monde du Business », il s’attaque donc au...

[Podcast] L’essence du Data Art et de la Data Visualisation

Nicholas Rougeux se définit comme un « data artiste » (« data artist » en anglais) et le moins qu’on puisse dire c’est que son talent pour visualiser les données est évident. Tellement évident même qu’il commercialise son travail sous forme de posters … et je m’en suis même fait offrir un pour mon anniversaire 🙂 Courez voir son blog (www.c82.net) si vous manquez d’inspiration ou si vous voulez voir ce qu’il se fait de mieux en matière de « dataviz »....

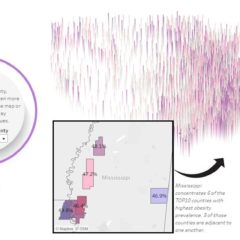

Tutoriel: comment créer un Joyplot sous Tableau

Après vous avoir expliqué comment créer une hexmap isométrique, je m’attaque à un sujet plus difficile : créer un joyplot sous Tableau. J’ai utilisé un joyplot dans la visualisation que j’ai soumise à l’IronViz. Comme ce type de graphique est relativement rare est que j’ai un peu galéré pour parvenir au résultat escompté, je me suis dit qu’un tutoriel serait le bienvenu. Sommaire Définition du joyplot Origine du nom « Joyplot » Tutoriel de création de joyplot sous...

Covid-19 : impact sur le marché du conseil IT et perspectives

La crise du Covid-19 a eu un impact énorme sur le marché de l’informatique. Certains pans de ce secteur en ont profité (pensez à tout ce qui tourne autour du télétravail) mais d’autres ont également énormément souffert. C’est le cas du conseil en IT. D’après une étude de Whoz publiée en Juin 2020, 13% des projets avait été abandonnés et 21% avaient été mis « on hold ». Jean-Philippe Couturier, le CEO de Whoz, revient dans ce podcast...

Repenser l’expérience client au musée grâce aux (Big) data

Comment les Big Data peuvent-elles aider les musées à se réinventer ? Quelles techniques de collecte de données mettre en œuvre pour mieux comprendre les visiteurs ? Comment utiliser les données pour fidéliser les visiteurs ? Dans cet article nous proposons une série de réflexions sur les dispositifs muséographiques actuels, futurs, et sur les initiatives « data » qui peuvent être mises en place afin de améliorer l’expérience client et fidéliser les visiteurs. Sommaire Introduction Les musées à...

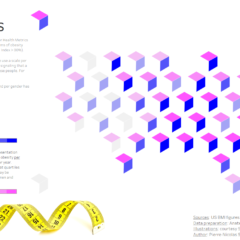

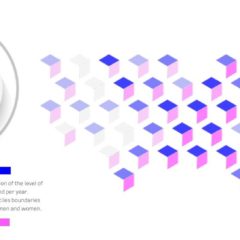

Hexmap isométrique sous Tableau : un guide pas-à-pas

Dans le cadre de ma participation à l’Iron Viz 2020, j’ai créé un nouveau type de visualisation sous Tableau qui m’a valu beaucoup de commentaires positifs. Je l’ai appelé « hexmap isométrique’ (isometric hexmap). Dans cet article j’explique comment reproduire ce type de représentation et vous donne accès aux fichiers sources. Vous pouvez accéder à la version interactive sur Tableau Public. Si cette visualisation vous plaît, n’hésitez pas à laisser un commentaire et à la réutiliser. Principe...

Tableau Iron Viz 2020 : réflexions sur ma première participation

L’Iron Viz est le « championnat du monde » qui couronne les 3 meilleurs développeurs Tableau, un logiciel qui permet de visualiser les données. Cette année j’ai décidé d’y participer également (accéder à ma contribution ici). Dans cet article je reviens sur mon expérience, ce que la préparation du concours m’a appris et sur les difficultés que j’ai rencontrées. 6 conseils pour une bonne #Dataviz Passez du temps à choisir une source de données principale de qualité et...

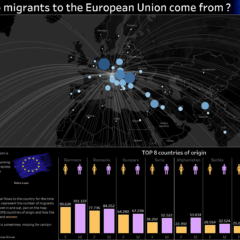

Migrations en Europe : visualisation interactive sous Tableau

Comment représenter de manière attractive les migrations vers les pays de l’Union Européenne ? C’est la question à laquelle j’ai voulu répondre en utilisant Tableau Software. Si la question était simple, la réponse était loin de l’être et il m’a fallu quelques jours de réflexion pour trouver la bonne solution et le bon design. Je vous la présente ci-dessous avec le modus operandi pour la reproduire. Seulement pour nos abonnés : analyses et conseils marketing exclusifs...

De quoi faut-il parler sur Linkedin pour avoir des likes et des commentaires ?

Après avoir analysé mes meilleures heures de publication sur Linkedin, je me suis attaqué à un problème autrement plus difficile : déterminer les sujets qui me rapportaient le plus de vues et d’engagement sur Linkedin. Dans le billet d’aujourd’hui je vais vous montrer les résultats que j’ai pu obtenir en utilisant 2 outils spécifiques : Anatella pour l’extraction et la préparation des données d’une part, et Tableau pour l’exploration et la visualisation des résultats d’autre part....

Quelle est l’heure idéale pour poster sur Linkedin ?

Dans leur tentative de comprendre le fonctionnement de l’algorithme de Linkedin, les utilisateurs de ce réseau social débattent souvent de l‘heure idéale pour mettre son contenu en ligne. J’ai décidé de faire quelques analyses pour faire la part de vérité et de mythes dans cette histoire. Si ce genre d’analyse vous intéresse et si vous souhaitez faire la même chose avec vos données, inscrivez-vous à notre newsletter (ci-dessous). Lorsque la procédure et les outils seront prêts...

Fuzzy Matching dans Alteryx : tests, résultats et comparaison

Le fuzzy matching est une technique bien utile dans nombre de situations courantes. Alteryx propose une fonctionnalité de Fuzzy Matching que j’ai comparée à celle d’Anatella. J’avais d’ailleurs déjà parlé de Fuzzy Matching dans ce billet. Les fonctionnalités de Fuzzy Matching dans Tableau Prep builder n’en étant pas vraiment, j’ai voulu voir ce que Alteryx avait dans le ventre. Au final Anatella donne de meilleurs résultats et la programmation du processus d’ETL est beaucoup plus efficace....

Fuzzy matching : comparaison de 4 méthodes pour réaliser une jointure

Dans un précédent article j’ai partagé avec vous une solution pour réaliser un fuzzy matching entre 2 tables différentes. J’avais alors comparé 2 solutions d’ETL (Extract Transform Load). Tableau Prep Builder n’avait pas permis d’aboutir au résultat désiré. Je m’étais donc tourné vers Anatella. Dans l’article d’aujourd’hui j’explore les différents algorithmes de Fuzzy Matching disponibles dans cet outil et leurs résultats. Comme vous le verrez, un algorithme ressort grand gagnant de la confrontation. Introduction Quand vous...

Pour contrer les bulles de filtres cultivez les « maillons faibles » de votre réseau

La théorie des bulles de filtres est une fois de plus remise en question. Cette fois-ci c’est une étude américaine qui montre que c’est la composition de notre réseau qui détermine si nous serons piégés dans une bulle de filtres ou pas. En particulier, les « connexions faibles » sont cruciales pour être exposés à des contenus diversifiés. On vous explique tout dans cet article. Si vous n’avez que 30 secondes une étude américaine (une de plus) remet...

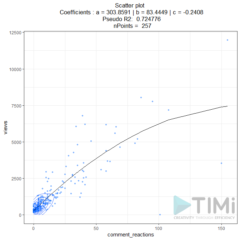

Algorithme de Linkedin : 1 réaction vous rapportera 83 vues

Comment influence l’algorithme de Linkedin ? Quelle est la corrélation entre le nombre de likes ou commentaires, et le nombre de vues dans Linkedin ? Tout le monde cherche à comprendre l’algorithme de Linkedin. Certains essayent même de le hacker. Si les hypothèses fleurissent, personne ne sait vraiment comment ça marche. Je me suis retroussé les manches et aujourd’hui je vous explique, modèle statistique à l’appui. BONUS : recevez votre analyse statistique personnelle Je vous propose...

Fuzzy matching entre tables : 2 ETL comparés (Tableau Prep Builder vs. Anatella)

Si vous manipulez des données à des fins d’analyses et/ou de visualisations, vous avez sans doute déjà rencontré ce problème. Vous devez faire une jointure entre 2 bases de données mais les entrées dans le champ de référence ne sont pas exactement les mêmes. Différences d’orthographe, nomenclatures différentes, … les raisons sont multiples et variées. Dans le cadre d’une recherche que je fais pour visualiser les flux migratoires, j’ai été confronté à ce problème. J’ai dû...

Nouvel algorithme Linkedin : voici quoi faire pour rester visible

Les ingénieurs de Linkedin ont publié le 12 Mai 2020 la recette de leur nouvel algorithme. Le moins qu’on puisse dire c’est que ça change complètement les pratiques pour rendre un post viral. Si vous voulez que vos posts Linkedin soient encore vus (et accessoirement deviennent populaires), lisez attentivement ce qui suit. Je vous conseille également de lire mon analyse sur les thématiques à aborder pour récolter plus de vues. Je réalise actuellement une analyse sur...

Assurances connectées : fiabilité des bracelets connectés et hacking

Dans l’article d’aujourd’hui nous allons parler de la fiabilité des bracelets connectés de type fitbit et de leur hacking. Le phénomène est encore peu répandu en Europe mais aux Etats-Unis c’est devenu un vrai problème. Ce sont les propriétaires de ces bracelets connectés qui essayent de les hacker. Pourquoi ? Nous vous expliquons tout dans cet article. Nous en profitons pour vous livrer une analyse du secteur de l’assurance santé connectée. Le résumé Certaines compagnies d’assurance...

Comment hacker les algorithmes de recommandation ?

Hacker un algorithme de recommandation est une opération qui peut rapporter gros. En effet, certains algorithmes de recommandation sont omniprésents dans notre vie digitale et orientent très fortement nos comportements. En fait, nous sommes devenus dépendants des algorithmes sans nous en rendre compte. On se souviendra par exemple que 35% des achats sur Amazon sont la conséquence directe d’une recommandation algorithmique. 80% des films regardés sur Netflix et 75% des vidéos sur YouTube sont suggérés par...

Simon Weckert, artiste allemand a réussi à hacker google maps

Hacker un algorithme ? Ça n’est pas forcément si compliqué que cela et les conséquences économiques peuvent être importantes. En effet, tout aujourd’hui est régi par des algorithmes, en particulier les algorithmes de recommandation. Détourner à son profit un algorithme de recommandation peut donc avoir des conséquences économiques considérables. Dans l’article d’aujourd’hui nous souhaitons vous présenter le projet de Simon Weckert, un artiste allemand qui a « hacké » l’algorithme de Google Maps. Nous vous informons également que nous...

2025 : la fin des algorithmes de personnalisation ?

A l’heure où Amazon réalise déjà 35% de son CA grâce à la recommandation algorithmique (voir infographie ci-dessous) et lance deux nouveaux outils de personnalisation (Discover et Showroom), le cabinet Gartner annonce lui la fin des algorithmes de personnalisation à l’horizon 2025. Cette annonce, paradoxale, nous sembler devoir mériter une analyse approfondie. Sommaire Infographie sur les algorithmes de recommandation A quoi sert la personnalisation algorithmique Pourquoi abandonner la personnalisation algorithmique ? Problème 1 : collecte et...

[Podcast] promesses et challenges de l’intelligence artificielle avec Ségolène Martin

Dans le podcast de cette semaine nous recevons Ségolène Martin, la CEO de Kantify, une entreprise spécialisée dans l’intelligence artificielle, basée à Bruxelles. L’intelligence artificielle est sans aucun doute un des sujets « à la mode » depuis quelques mois mais nous essayerons, dans ce podcast, d’aller au-delà des clichés. Nous nous intéresserons dès lors à la véritable valeur ajoutée de l’intelligence artificielle en entreprise, mais également aux difficultés que le lancement d’un tel projet représente. En particulier...

Comment réaliser de meilleures analyses marketing grâce au Big Data

Le progrès technologique nous permet aujourd’hui de profiter de conditions de vie incomparables. Maîtrise de l’espace, maîtrise de la reproduction, maîtrise de l’information sont des défis déjà relevés. La maîtrise du temps reste toutefois hors d’atteinte. Beaucoup des obsessions des Humains tournent autour de la maîtrise de cette ressource qui nous est offerte à notre naissance en une quantité désespérément finie : le temps. Rester jeune, vivre vieux, perpétuer sa mémoire, prédire le futur sont quelques...

![Data preparation : définition, exemples, conseils [guide 2023]](https://www.intotheminds.com/blog/app/uploads/desk-research-data-graphs-figures-240x240.jpg)

![Les 5 niveaux de la data visualisation : exemples et conseils [guide ultime]](https://www.intotheminds.com/blog/app/uploads/The-Air-We-Breathe-IronViz-Final-240x240.jpg)

![Data visualisation : définition, exemples, outils, conseils [guide 2023]](https://www.intotheminds.com/blog/app/uploads/data-viz-240x240.jpg)

![[Podcast] L’apprentissage des outils numériques aux enfants](https://www.intotheminds.com/blog/app/uploads/child-computer-coding-240x240.jpg)

![[Podcast] L’essence du Data Art et de la Data Visualisation](https://www.intotheminds.com/blog/app/uploads/collage-closeup-240x240.jpg)

![[Podcast] promesses et challenges de l’intelligence artificielle avec Ségolène Martin](https://www.intotheminds.com/blog/app/uploads/Segolene-martin-kantify-podcast-240x240.jpg)